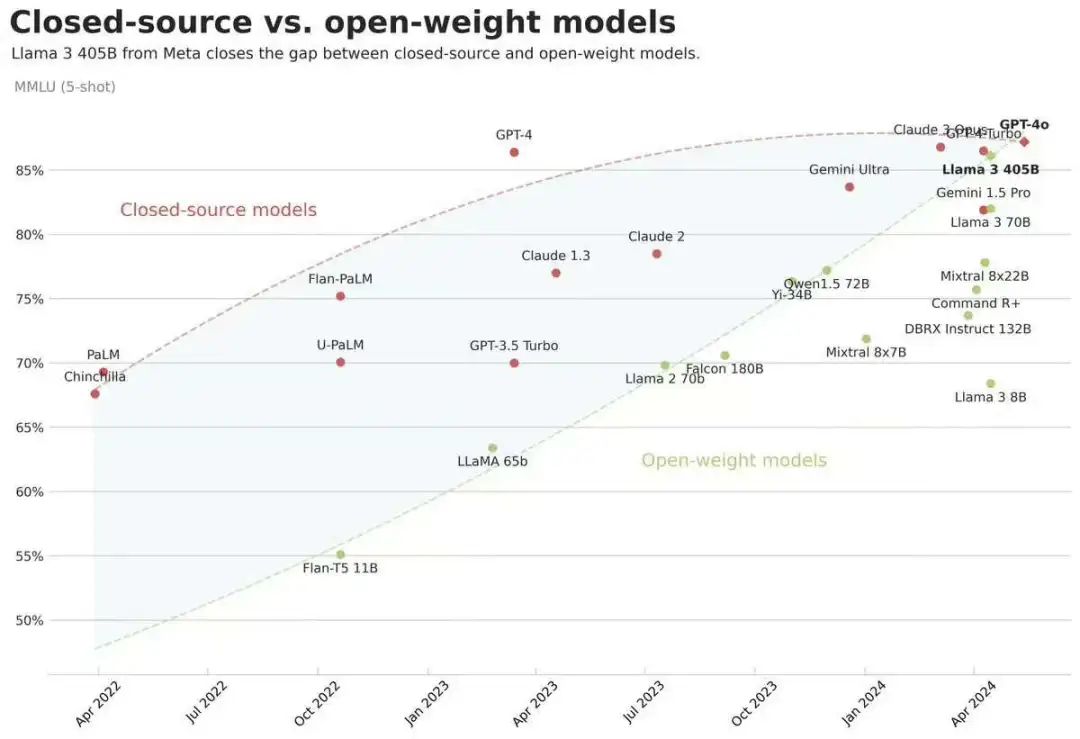

Llama3.1系列模型正式開源,最大405B,閉源模型的統(tǒng)治時代將迎來結(jié)束?

Meta開源了Llama3.1系列模型,最大參數(shù)規(guī)模為405B,開源也是好起來了,榜單指標直逼GPT4-o。

開源追上閉源模型不再是夢!Llama系列模型確實是開源界的頭部,真金白銀砸出來的就是不一樣。

不過現(xiàn)在大家也都知道,榜單效果和真實使用效果也不是完全正比的,后面看看對lmsys戰(zhàn)榜單,還有大家的實測效果吧!

HF: https://huggingface.co/collections/meta-llama/llama-31-669fc079a0c406a149a5738f

Llama3.1系列模型細節(jié)

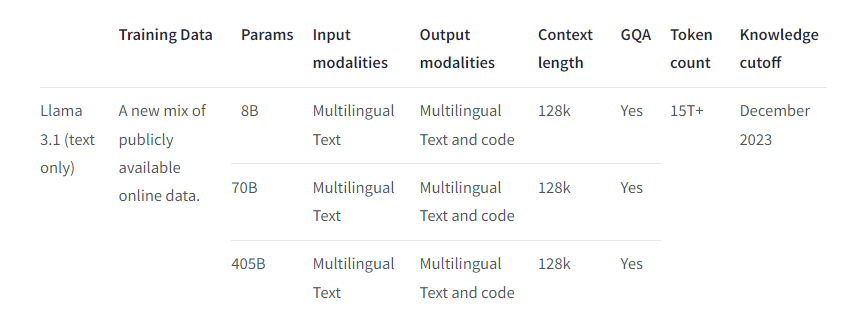

- 15T Tokens預(yù)訓(xùn)練;占比知識50、數(shù)學(xué)25、代碼17、語言8

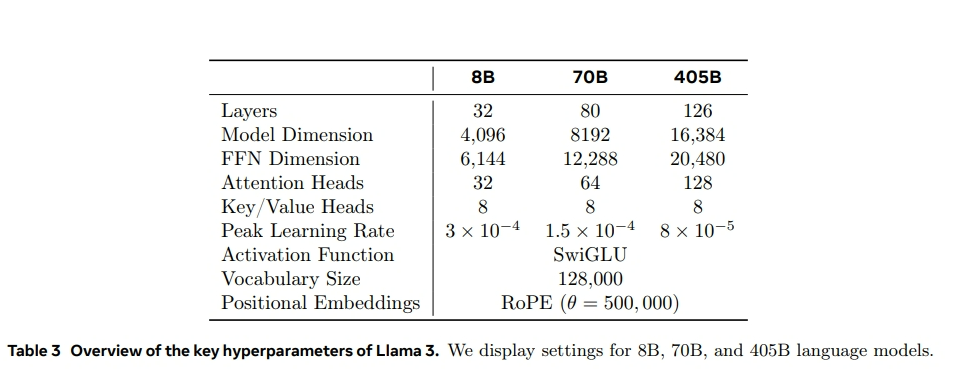

- 8B、70B、405B的模型均采用GQA;

- 405B模型,有126層,詞表大小128256,隱藏層維度16384;8B和70B模型與llama3一樣就不介紹了;

- 支持上下文長度128k;

- 支持多語言,包括英語、法語、德語、印地語、意大利語、葡萄牙語、西班牙語和泰語;當然其他語言也可以使用,只是沒有針對性進行安全測試。

- instruct模型微調(diào)使用了公開可用的指令數(shù)據(jù)集,以及超過2500萬的合成數(shù)據(jù)

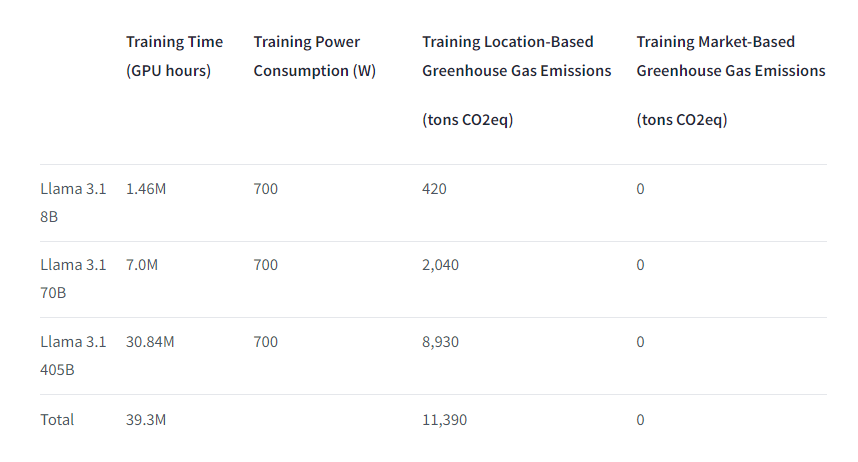

- 8B模型預(yù)訓(xùn)練用了146萬 GPU小時,70B模型預(yù)訓(xùn)練用了700萬 GPU小時,405B模型預(yù)訓(xùn)練用了3084萬 GPU小時;

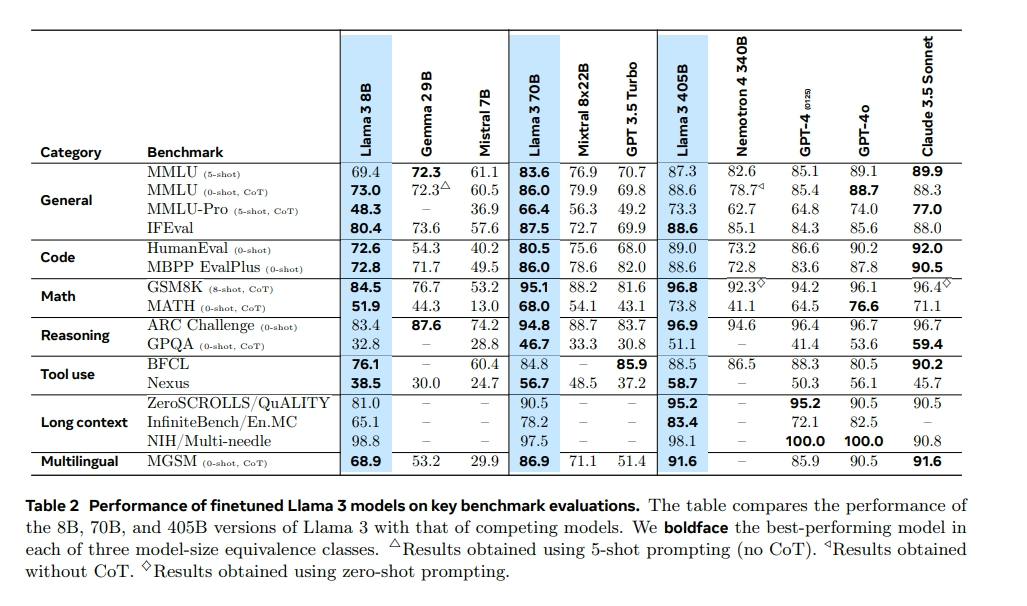

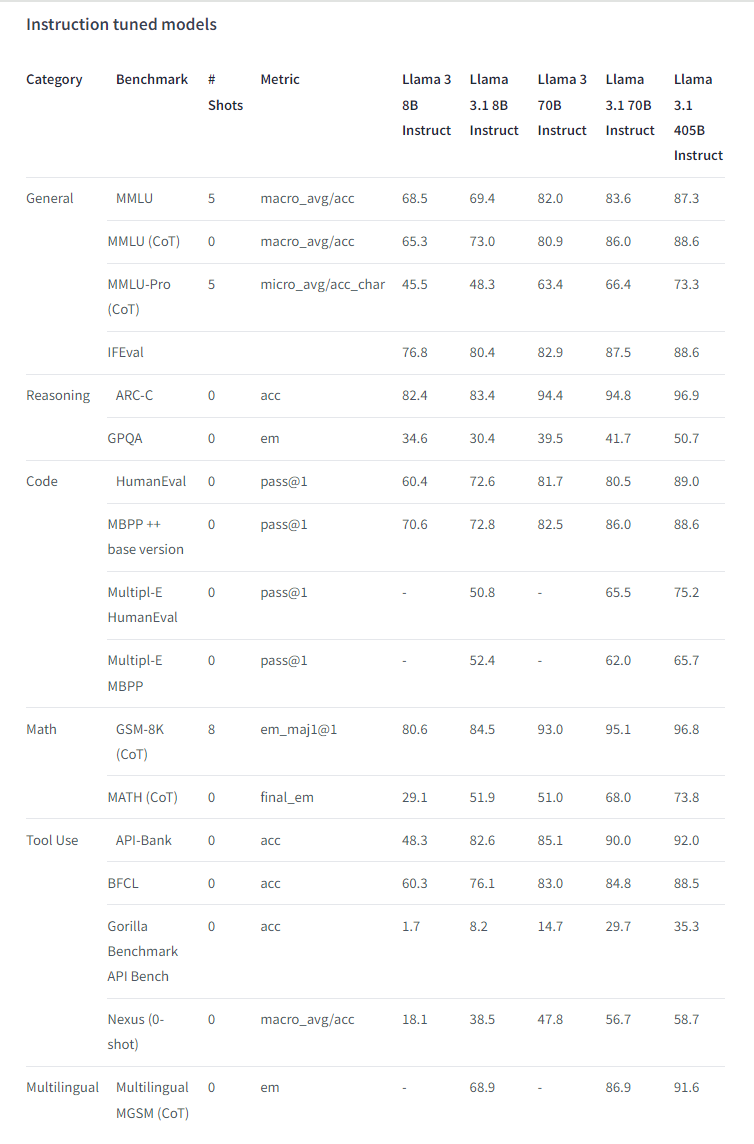

Llama3.1系列模型效果

Llama3.1系列的8B和70B模型的效果,普遍好于Llama3系列模型。尤其是Instruct模型提升較高,特別是通用、代碼、數(shù)學(xué)和工具使用四個方面,大幅提高;額外添加的合成數(shù)據(jù),應(yīng)該是關(guān)鍵。

模型使用

Llama3-405B模型整體結(jié)構(gòu)沒有變化,所有直接transformers走起。

import transformers

import torch

model_id = "meta-llama/Meta-Llama-3.1-8B-Instruct"

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device_map="auto",

)

messages = [

{"role": "system", "content": "You are a pirate chatbot who always responds in pirate speak!"},

{"role": "user", "content": "Who are you?"},

]

outputs = pipeline(

messages,

max_new_tokens=256,

)

print(outputs[0]["generated_text"][-1])當然為了加速或者節(jié)省顯存,也可以vllm、ollama、llamacpp等框架來加載量化模型,這里就不詳細介紹了。

寫在最后

不過405B模型太大了,部署成本太高了,即使效果很棒,但有多少企業(yè)有資格玩一把呢?

個人玩家就更不用說了,光模型大小就820G,別說有沒有顯卡,也許都沒有820G磁盤空間下載都沒資格,太難了!

不過后面各大平臺(阿里、百度、SiliconFlow)應(yīng)該會有調(diào)用API,到時候體驗效果也不費事兒。

又有新工作可做了,應(yīng)該很快會有Chinese-Llama-3.1工作出來,沒資源的小伙伴,等就完事兒了。

最后,Qwen系列是不是也要加把勁了,都給我卷起來!?

本文轉(zhuǎn)載自 ??NLP工作站??,作者: 劉聰NLP