將所有有用的信息整合到一張圖片中:大型多模態(tài)模型能夠進(jìn)行圖片內(nèi)的學(xué)習(xí)

論文題目:

All in a Single Image: Large Multimodal Models are In-Image Learners

論文鏈接:

??https://arxiv.org/abs/2402.17971??

開源鏈接:

https://github.com/AGI-Edgerunners/In-Image Learning

01 動(dòng)機(jī)和背景

?

近年來,大語言模型取得了顯著的成功。盡管 GPT-4V 有強(qiáng)大的文本理解和圖片輸入能力,但仍存在許多問題。例如,在讀取一張復(fù)雜圖片時(shí),無法完全理解圖像中呈現(xiàn)的信息。在本文中,我們提出了一種新的上下文學(xué)習(xí)機(jī)制——In-Image Learning,它將所有可能有用的信息,包括樣例,視覺線索和思維鏈等等整合在一張圖片上,有助于釋放 GPT-4V 的性能。

02 方法

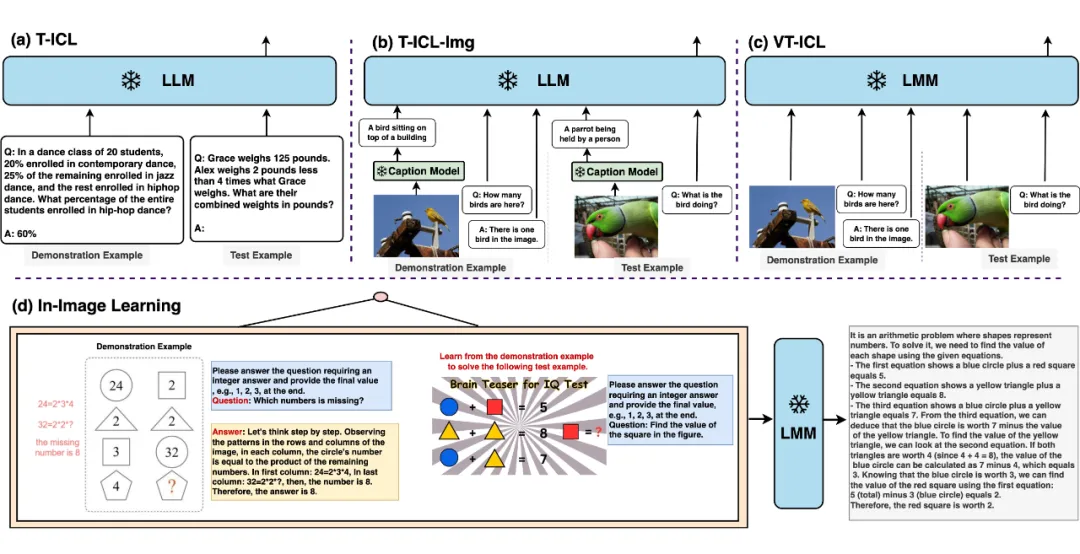

- T-ICL with additional image-to-text models(T-ICL-Img):為了將大型語言模型(LLMs)從自然語言處理(NLP)任務(wù)適配到多模態(tài)任務(wù),一個(gè)常見的策略是將相應(yīng)的圖像轉(zhuǎn)換成文本描述。

2. Visual-text interleaved in-context learning(VT-ICL):盡管 T-ICL-Img 取得了顯著的效果,但在將視覺輸入轉(zhuǎn)換為文本描述時(shí)存在丟失信息的風(fēng)險(xiǎn)。

為了避免這個(gè)問題,可以為上下文學(xué)習(xí)準(zhǔn)備交錯(cuò)的圖文對(duì),直接整合到大語言模型(LLMs)中。

- In-Image Learning(IIL):GPT-4V 在理解圖像中的符號(hào)和數(shù)字等視覺線索方面具有很高的熟練度。

在本文中,我們將樣例范本、視覺線索、思維鏈整合在一張圖片上。將有價(jià)值的信息整合到單一圖像中提供了三個(gè)主要好處。

首先,它有效地傳達(dá)了僅憑文字無法準(zhǔn)確描述的復(fù)雜圖像。其次,它允許信息被放置在圖像的任何位置,不像之前的上下文學(xué)習(xí)方法那樣對(duì)信息的排序敏感。第三,僅使用一個(gè)圖像作為輸入減少了對(duì)冗長輸入的需求,從而減輕了輸入負(fù)擔(dān)并避免超出大模型(LMMs)的輸入限制(注意:我們沒有包含任何提示在測(cè)試樣本上)。

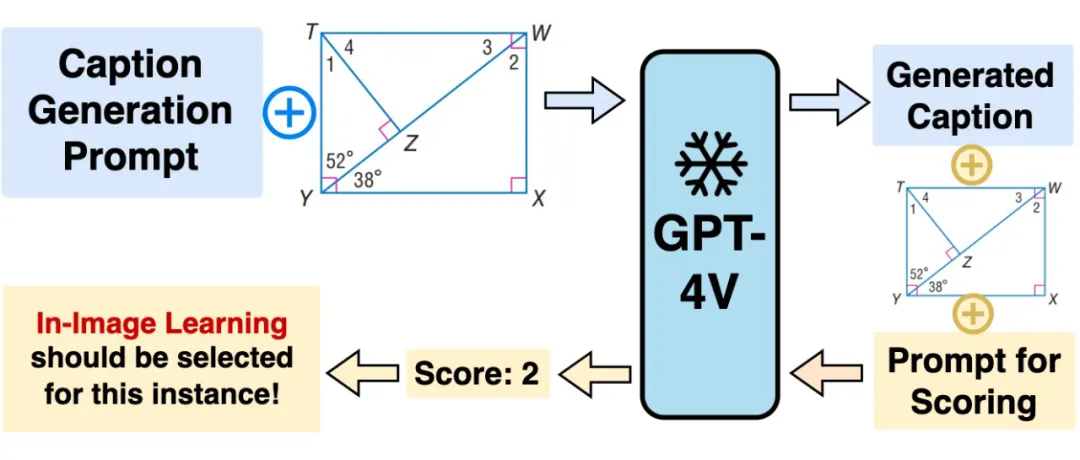

- Selection:本文提出的 In-Image Learning 擅長處理僅用文本無法準(zhǔn)確描述的復(fù)雜圖像,而 VT-ICL 能更好地利用文本信息來提升那些可以被文本輕易描述的圖像的性能。

為了結(jié)合這兩種方法的優(yōu)點(diǎn),我們使用 GPT-4V 作為一種選擇器。首先提示 GPT-4V 為給定數(shù)據(jù)示例的圖像生成描述。然后讓 GPT-4V 根據(jù)生成的描述與圖像進(jìn)行對(duì)比打分,范圍從 1 到 4 分。1 或 2 分表明圖像難以描述,使其更適合 In-Image Learning 方法,3 或 4 分表明圖像易于描述,使用 VT-ICL 方法更適合這個(gè)數(shù)據(jù)示例。

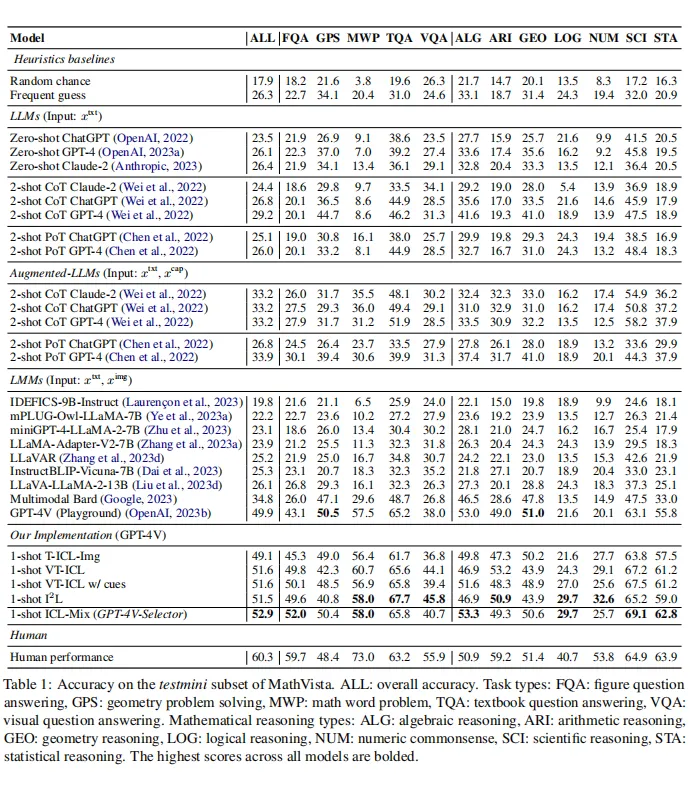

03 實(shí)驗(yàn)結(jié)果

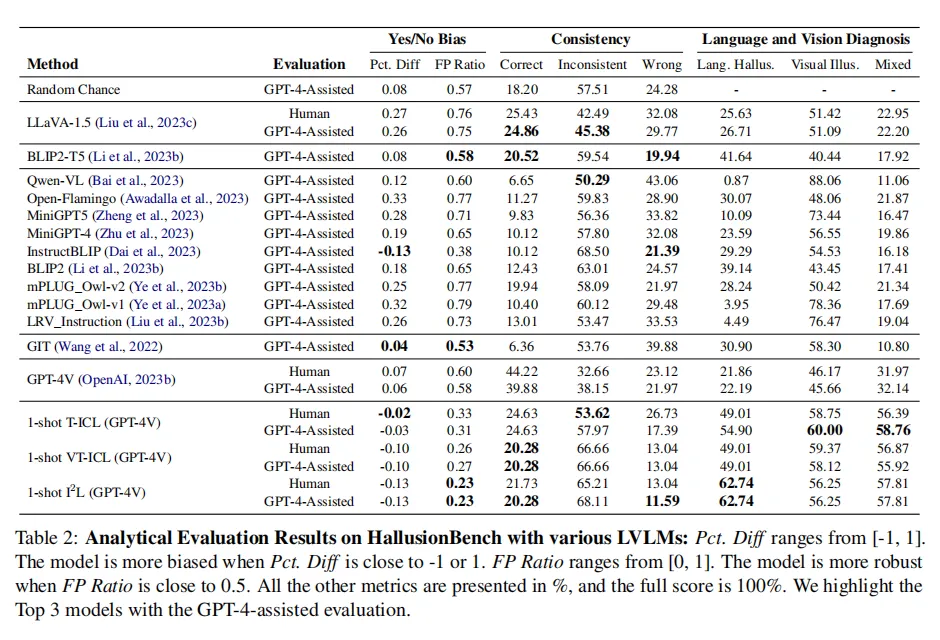

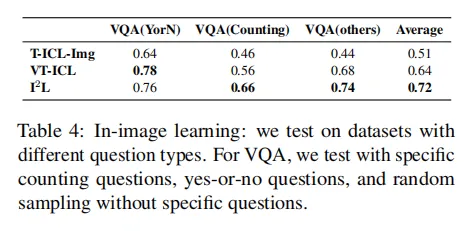

我們?cè)?個(gè)數(shù)據(jù)集上進(jìn)行了測(cè)試,分別是:(1)MathVista;(2)HallusionBench;(3)VQA.

MathVista minitest 數(shù)據(jù)集上不同方法和模型上的測(cè)試結(jié)果如下:

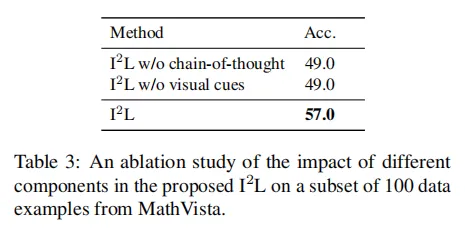

我們使用 MathVista 數(shù)據(jù)集上的隨機(jī) 100 個(gè)數(shù)據(jù)進(jìn)行消融實(shí)驗(yàn),結(jié)果如下,說明 In-Image Learning 方法能激發(fā) GPT-4V 的潛力。

04 總結(jié)

在本文中,我們提出了 In-Image Learning 的方法,以增強(qiáng) GPT-4V 的能力。In-Image Learning 將示范例子、視覺線索和指令結(jié)合到單一圖像中。

In-Image Learning 擅長處理復(fù)雜圖像,而 VT-ICL 更適合那些可以輕易通過文本描述的圖像。為了在多模態(tài)任務(wù)中利用這兩種方法的優(yōu)勢(shì),我們提議使用 GPT-4V 作為選擇器,以確定給定任務(wù)中每個(gè)多模態(tài)數(shù)據(jù)示例的適當(dāng)方法。

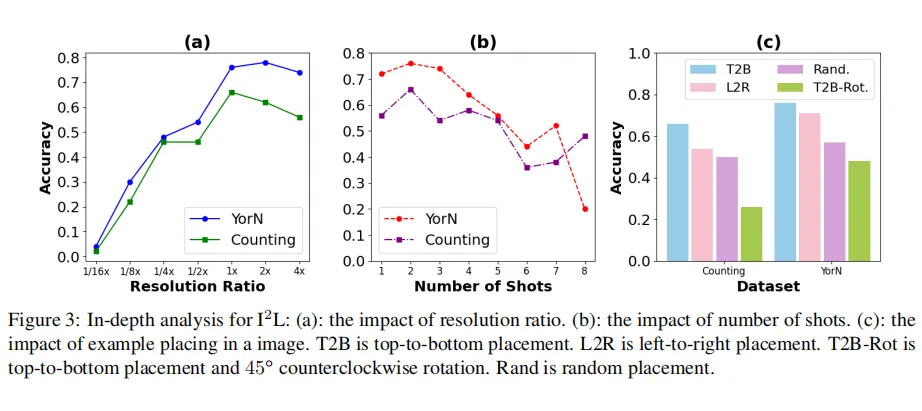

通過在 MathVista 和 Hallusionbench 上的全面實(shí)驗(yàn),我們展示了 In-Image Learning 在復(fù)雜推理任務(wù)中的有效性,以及在減輕語言幻覺和視覺錯(cuò)覺方面的作用。我們還檢查了圖像分辨率和示范例子位置等因素的影響,進(jìn)一步凸顯了圖像內(nèi)學(xué)習(xí)的多功能性和潛力。

對(duì)于未來的工作,我們計(jì)劃在更多的文字難以描述的任務(wù)上驗(yàn)證 In-Image Learning 的有效性,以及通過訓(xùn)練的方式來加強(qiáng) In-Image Learning。

本文轉(zhuǎn)自 PaperWeekly ,作者:讓你更懂AI的