關(guān)于最強 Meta Llama 3.1,你所應(yīng)該了解的

Hello folks,我是 Luga,今天我們來聊一下 LLM(大型語言模型) 生態(tài)相關(guān)技術(shù):Meta Llama 3.1,一個被稱為世界上最大、最有能力、最先進的開源人工智能模型。

2024年,對于人工智能領(lǐng)域來說可謂意義非凡。繼 OpenAI 推出備受贊譽的 GPT-4o mini后,Meta 的 Llama 3.1 模型亦在 7月23日 驚艷亮相,再一次掀起了新一輪人工智能熱潮。這款全新的大型語言模型憑借其卓越的技術(shù)實力和無限的應(yīng)用前景,迅速在全球范圍內(nèi)引發(fā)了廣泛關(guān)注。

Meta Llama 3.1 的嶄露頭角,標志著生成式人工智能邁向了一個全新的里程碑。這款模型不僅在處理復(fù)雜語言任務(wù)上展現(xiàn)出了超群的表現(xiàn),更在準確性、速度和可擴展性等關(guān)鍵指標上達到了前所未有的高度,徹底刷新了業(yè)內(nèi)的認知水平。其卓越的性能源于 Meta 團隊長期以來在深度學(xué)習(xí)和自然語言處理領(lǐng)域的不懈探索,匯聚了眾多頂尖科學(xué)家和工程師的智慧結(jié)晶。

更為難能可貴的是,Meta Llama 3.1 作為一款開源模型,為全球的研究人員和開發(fā)者提供了一個寶貴的實踐平臺。憑借這一強大工具,科研人員可以更深入地探索人工智能的奧秘,而開發(fā)者們也將獲得充分的創(chuàng)新空間,將人工智能的力量釋放到各個應(yīng)用場景中。由此可見,Meta Llama 3.1 的誕生不僅是人工智能技術(shù)的一大飛躍,更為推動整個行業(yè)的可持續(xù)發(fā)展注入了新的動力。

一、如何定義及看待 Meta Llama 3.1 ?

作為這一開創(chuàng)性工程的發(fā)起人,Meta 核心人物馬克·扎克伯格在《開源人工智能是前進之路》一文中闡釋了公司對開放式人工智能的深切期許。他強調(diào),開源人工智能將為開發(fā)者、科技公司乃至整個社會帶來諸多裨益。首先,開放的代碼庫為創(chuàng)新開辟了無限可能,允許開發(fā)者根據(jù)特定需求定制模型;其次,開源助力人工智能技術(shù)的民主化進程,有助于降低應(yīng)用成本,解決數(shù)據(jù)安全隱患,避免供應(yīng)商鎖定;再者,透明度和社區(qū)審查將確保開源人工智能的可靠性和安全性,甚至超越封閉系統(tǒng)。

然而,事實上,馬克·扎克伯格的開源理念不僅體現(xiàn)在最新力作Llama 3.1之上,更植根于 Meta 長期以來的產(chǎn)品戰(zhàn)略。因此,某種意義上而言,我們不難發(fā)現(xiàn),通過推廣開源框架如 PyTorch、開放數(shù)據(jù)集等,Meta 一直在為人工智能生態(tài)系統(tǒng)的建設(shè)貢獻自身的力量。

毫無疑問,Llama 3.1 的發(fā)布標志著 Meta 在開源人工智能道路上邁出了堅實的新步伐。通過開放獲取強大的人工智能能力,將有助于構(gòu)建一個更加多元、包容的技術(shù)生態(tài)系統(tǒng),促進創(chuàng)新、維護公平,最終讓人工智能的力量惠及全人類。

Llama 3.1 系列包括三種型號:Llama 3.1 8B、Llama 3.1 70B 和 Llama 3.1 405B。所有這三款模型現(xiàn)在都具備了改進的 128 K上下文長度,大大提升了其處理復(fù)雜任務(wù)的能力。此外,Meta 現(xiàn)已開放了使用 Llama 模型輸出來改進其他模型的功能,為開發(fā)者提供了更強大的工具和靈活性。

此外,Meta 在超過 150 個基準數(shù)據(jù)集上對 Llama 3.1 系列模型進行了廣泛評估。這些評估不僅涵蓋了模型在各類任務(wù)中的表現(xiàn),還包括通過多次人類評估,將這些模型與現(xiàn)實世界中的其他頂尖競爭模型進行比較。評估結(jié)果顯示,Llama 3.1 405B 在性能上與當前領(lǐng)先的基礎(chǔ)模型如 GPT-4、GPT-4o 和 Claude 3.5 Sonnet 具有競爭力。基于這些結(jié)果,Meta 現(xiàn)在自豪地聲稱,Llama 3.1 405B 是目前世界上最大、最有能力的公開基礎(chǔ)模型。

不僅如此,較小的 Llama 3.1型號(8B和70B)在性能上也展示出與同類封閉式和開源模型相媲美的競爭力。無論是在處理能力還是在應(yīng)用靈活性方面,Llama 3.1系 列都為開發(fā)者和研究人員提供了卓越的選擇,推動了生成性人工智能的進步和發(fā)展。

二、Meta Llama 3.1 基礎(chǔ)特性概述

眾所周知,Llama 3.1 版本誕生之際,引領(lǐng)著人工智能領(lǐng)域踏上了一個全新的里程碑。這款堪稱當今最先進的大型語言模型,匯聚了 Meta 團隊在深度學(xué)習(xí)和自然語言處理領(lǐng)域多年來的卓越研究成果。其卓越的表現(xiàn),不僅在一般知識儲備、多語種翻譯、邏輯推理等傳統(tǒng)任務(wù)上展現(xiàn)出了無與倫比的實力,更突破性地在諸如合成數(shù)據(jù)生成、模型蒸餾等前沿領(lǐng)域擁有了廣闊的創(chuàng)新空間。

1.模型增強

除了尖端的 405B 參數(shù)旗艦版本外,Llama 3.1 還推出了增強版的 8B 和 70B 小型模型。這些升級版本不僅支持了多種語言,更將上下文長度拓展至128K,大幅提升了長格式文本處理、多語種對話交互、代碼生成輔助等高級應(yīng)用場景的性能表現(xiàn)。可以說,這一系列型號的推出,將從根本上重塑人類與人工智能之間的交互體驗。

2.開源理念承諾

除了上述的模型增強特性之外,最令人鼓舞的是,Llama 3.1 忠實地秉承了Meta一貫的開源理念。該系列模型不僅在 Meta 的開源平臺上提供下載,更與 Hugging Face 等知名社區(qū)建立了合作,確保全球開發(fā)者都能公平獲取這一人工智能力作。基于這一強大工具,開發(fā)者們可以自由定制,將其應(yīng)用于各種場景,無論是改進其他模型,抑或在本地、云端等不同環(huán)境中部署運行,皆可盡展所長。

3.無與倫比的先進性

在一般知識儲備方面,Llama 3.1 405B 展現(xiàn)出了人類水準的認知能力,涵蓋了廣博的學(xué)科知識和見解,可以隨意應(yīng)對各種復(fù)雜問題。更令人贊嘆的是,它在邏輯推理和語境轉(zhuǎn)換能力上堪稱登峰造極,能夠靈活地把握語義關(guān)聯(lián),合理地引申和過渡話題,彷佛擁有獨立的思維能力。

此外,Llama 3.1 405B 在數(shù)學(xué)運算、工具使用等專業(yè)領(lǐng)域也毫不遜色,可精準地進行復(fù)雜的計算和操作,為人類解決實際問題提供了強有力的輔助。值得一提的是,它在多語種自然語言處理上更是出類拔萃,能夠無縫轉(zhuǎn)換不同語種,為跨語言交流提供了極大便利。

4.全面的生態(tài)支持

事實上,在 Llama 3.1 面世之初,Meta就已與超過25家頂尖科技公司達成了深度合作,共同努力將這一革命性的人工智能模型融入各種平臺和環(huán)境中。在這些合作伙伴中,不乏像AWS、NVIDIA、Google Cloud 這樣的科技巨頭,它們均擁有業(yè)內(nèi)領(lǐng)先的云計算和硬件加速能力,確保了Llama 3.1 可以毫無阻礙地在各種云平臺上高效運行。

除了云服務(wù)商,一些專注于人工智能的創(chuàng)新公司也加入了 Llama 3.1 的生態(tài)陣營。他們致力于為用戶提供優(yōu)化的部署和管理解決方案,讓這款人工智能模型能夠在本地環(huán)境或邊緣設(shè)備上流暢發(fā)揮效能,滿足不同場景下的應(yīng)用需求。

三、Meta Llama 3.1 架構(gòu)解析

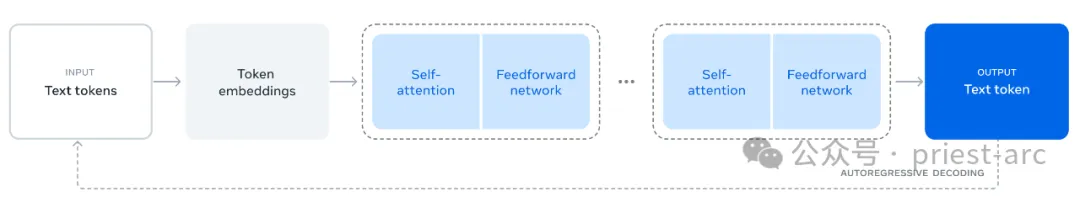

Llama 3 使用的是標準的密集 Transformer 架構(gòu)(Vaswani 等,2017 年)。在模型架構(gòu)方面,它與 Llama 和 Llama 2(Touvron 等,2023 年)沒有顯著的不同,主要來自于數(shù)據(jù)質(zhì)量和多樣性的改進以及訓(xùn)練規(guī)模的增加。

圖:Llama 3.1 模型架構(gòu)

相比于 Llama 3,我們確實做了一些小的修改:

- 使用了分組查詢注意力機制(GQA;Ainslie 等,2023),并配備了8個鍵值頭,以提高推理速度并減少解碼期間鍵值緩存的大小。

- 采用了一種注意力掩碼,防止同一序列中不同文檔之間的自注意力。在標準預(yù)訓(xùn)練期間,這一變化的影響有限,但在非常長的序列上進行持續(xù)預(yù)訓(xùn)練時,這一改動顯得尤為重要。

- 使用了包含 128K 詞匯的詞表。該詞匯表結(jié)合了來自 tiktoken3 分詞器的 100K 詞匯和額外的 28K 詞匯,以更好地支持非英語語言。與 Llama 2 的分詞器相比,新分詞器在一部分英語數(shù)據(jù)上的壓縮率從3.17個字符每詞提升到3.94個字符每詞。這使得模型在相同的訓(xùn)練計算量下可以“閱讀”更多的文本。我們還發(fā)現(xiàn),增加28K的非英語詞匯不僅改善了壓縮率,還提升了下游任務(wù)的性能,同時對英語分詞沒有影響。

- 將RoPE基頻超參數(shù)增加到 500,000。這使我們能夠更好地支持更長的上下文長度;Xiong等(2023)顯示這一數(shù)值在支持長達32,768的上下文長度時非常有效。

基于上述所述,Llama 3 405B 采用了126層的架構(gòu),具有16,384的詞元表示維度和128個注意力頭;具體細節(jié)請參見表3。這使得模型的規(guī)模大約符合我們的數(shù)據(jù)和訓(xùn)練預(yù)算(3.8 × 10^25 FLOPs)下的計算最優(yōu)縮放法則。

在架構(gòu)設(shè)計中,針對 Llama 3.1 訓(xùn)練方法,Llama 3.1 系列模型引以為傲的是其卓越的多語種支持能力。通過集成128K超大規(guī)模的令牌詞匯表,不僅涵蓋了主流語種,還囊括了眾多小語種,可以輕松駕馭包括英語、漢語、西班牙語、阿拉伯語在內(nèi)的數(shù)十種語言。這種語言上的廣度覆蓋,使得Llama 3.1孕育出了強大的跨語言理解和生成能力,為構(gòu)建多語種人工智能代理奠定了堅實基礎(chǔ)。

圖:Llama 3.1 模型家族

Llama 3.1 的訓(xùn)練過程可謂是一個層層遞進、循序漸進的嚴格流程,著眼于最終將其塑造成一款真正意義上的通用人工智能助手。整個過程大致可分為兩個主要階段:預(yù)訓(xùn)練和訓(xùn)練后調(diào)優(yōu)。

預(yù)訓(xùn)練階段是奠基之作。在這一階段,Meta 團隊將大規(guī)模的多語種文本語料庫轉(zhuǎn)化為離散化的標記,并以經(jīng)典的語言模型任務(wù)——下一個標記預(yù)測為目標,對大型語言模型(LLM)進行預(yù)訓(xùn)練。通過這一過程,模型不僅掌握了語言的內(nèi)在結(jié)構(gòu)和規(guī)律,更從海量文本中汲取了豐富的世界知識。

值得一提的是,Llama 3.1 預(yù)訓(xùn)練的規(guī)模之大前所未有。據(jù)悉,在論文中 Meta 透露,他們在 15.6 萬億個標記的語料庫上,采用了上下文窗口為 8K 標記的方式,對擁有405B參數(shù)的大模型展開了預(yù)訓(xùn)練。如此龐大的預(yù)訓(xùn)練規(guī)模,確保了模型對知識的廣博吸納。

預(yù)訓(xùn)練之后,還有一個持續(xù)預(yù)訓(xùn)練的環(huán)節(jié),將支持的上下文窗口拓展至 128K 標記。這一重要優(yōu)化不僅提升了模型處理長文本的能力,更為未來在文獻挖掘、知識總結(jié)等場景下的應(yīng)用奠定了基礎(chǔ)。

而真正將 Llama 3.1 的潛力無限釋放的,則是訓(xùn)練后調(diào)優(yōu)的這一決定性階段。在這里,預(yù)訓(xùn)練的語言模型雖已能理解文本內(nèi)容,但尚未獲得指令理解和意圖把握的能力。因此,Meta 采取了分階段的方式,通過數(shù)輪人工反饋,使模型逐步對齊指令調(diào)優(yōu)數(shù)據(jù),完成了直接偏好優(yōu)化(DPO)。

在這一環(huán)節(jié),Meta 還融入了諸如工具使用等創(chuàng)新功能,并專注優(yōu)化了編碼、推理等復(fù)雜任務(wù)的能力。可以說,訓(xùn)練后調(diào)優(yōu)階段是讓 Llama 3.1從一個被動的知識貯存者,蛻變成為一個主動的任務(wù)執(zhí)行者的關(guān)鍵所在。

此外,出于對模型安全性和倫理性的高度重視,Meta 在訓(xùn)練后調(diào)優(yōu)階段還融入了一系列安全緩解措施,努力促使 Llama 3.1 在提供強大功能的同時,也能秉持正確的價值觀和原則,真正造福人類。

Reference :

- [1] https://llama.meta.com/

- [2] https://about.fb.com/news/2024/07/open-source-ai-is-the-path-forward/