超越CLIP的多模態(tài)模型,只需不到1%的訓(xùn)練數(shù)據(jù)!南加大最新研究來(lái)了

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

火爆全網(wǎng)的AI繪畫(huà)你玩了嗎?

女?huà)z無(wú)限版、DALL·E2、Imagen……這些通過(guò)文字生成圖像的AI繪畫(huà)工具,背后的原理都是一個(gè)叫“CLIP”的模型,它是AI如何“理解”人類語(yǔ)義這一問(wèn)題的關(guān)鍵。

CLIP(Contrastive Language–Image Pre-training),是一種基于對(duì)比的圖片-文本學(xué)習(xí)的跨模態(tài)預(yù)訓(xùn)練模型,由OpenAI于去年1月發(fā)布。

它好用是好用,但一個(gè)大問(wèn)題是數(shù)據(jù)需求太大:4億個(gè)圖像文本對(duì)、256個(gè)GPU,這對(duì)許多公司和個(gè)人都很不友好。

對(duì)此,南加州大學(xué)的最新研究發(fā)現(xiàn)了一種基于本體的課程學(xué)習(xí)(Curriculum Learning)算法,只需不到1%的訓(xùn)練數(shù)據(jù)就能達(dá)到CLIP同款效果,甚至在圖像檢索方面表現(xiàn)更好。

新方法名為T(mén)OnICS(Training with Ontology-Informed Contrastive Sampling),相關(guān)論文已上傳到arXiv。

原理介紹

在介紹新方法之前,首先需要回顧一下CLIP。

CLIP的模型結(jié)構(gòu)其實(shí)非常簡(jiǎn)單:包括兩個(gè)部分,即文本編碼器和圖像編碼器。

兩者分別編碼后,將文本和視覺(jué)嵌入映射到相同空間中,使用對(duì)比學(xué)習(xí)的思想,將匹配的圖片-文本Embedding的距離拉近,將不匹配的Embedding拉遠(yuǎn)。

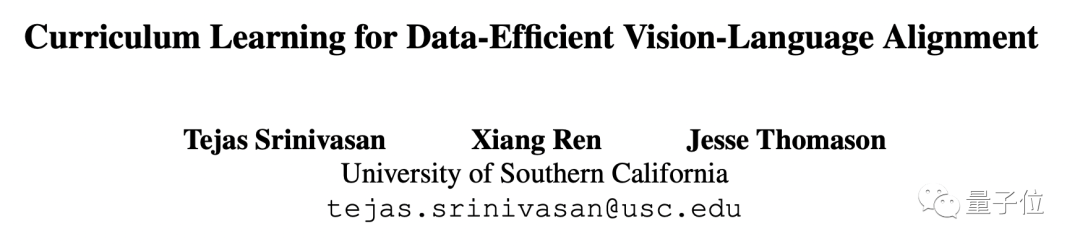

在此基礎(chǔ)上,TOnICS沒(méi)有選擇從頭訓(xùn)練圖像和文本編碼器,而是把單模態(tài)預(yù)訓(xùn)練模型BERT用于文本編碼,微軟的VinVL用于圖像編碼,并使用InfoNCE損失函數(shù)將它們彼此對(duì)齊。

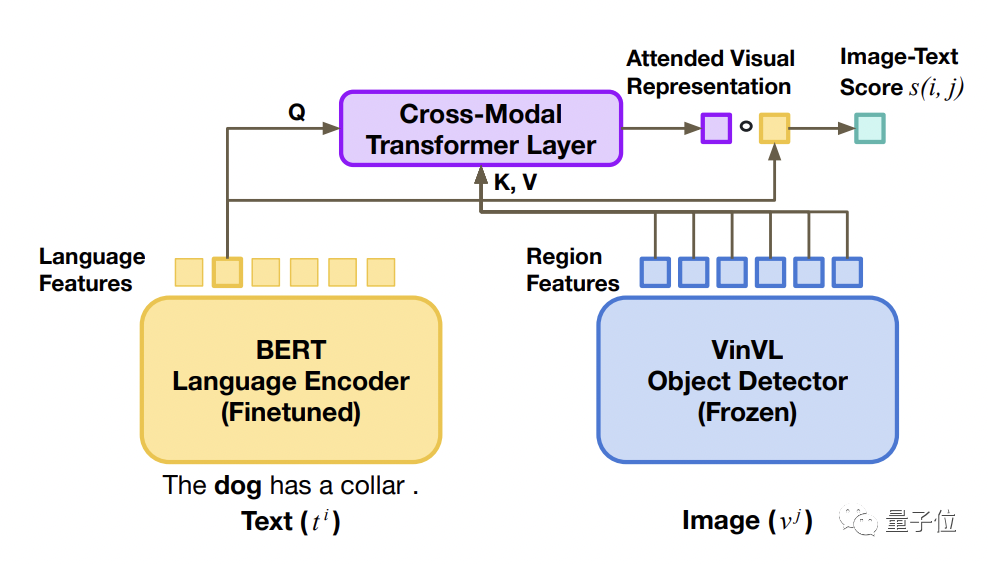

這是一種基于本體的課程學(xué)習(xí)算法,從簡(jiǎn)單的樣本開(kāi)始訓(xùn)練,方法是隨機(jī)抽樣小批次,并通過(guò)在圖像和文本輸入中加入相似的小批量數(shù)據(jù),逐步加大對(duì)比任務(wù)的難度。

舉個(gè)例子,在隨機(jī)抽樣生成的小批量數(shù)據(jù)中,如果想找到“一條叼著飛盤(pán)在草地上奔跑的狗”,只需要先找畫(huà)面中有狗的圖片即可,因?yàn)殡S機(jī)生成的圖像中包含狗的概率非常小。

也就意味著,隨機(jī)小批量抽樣將對(duì)比任務(wù)簡(jiǎn)化為了對(duì)象匹配。

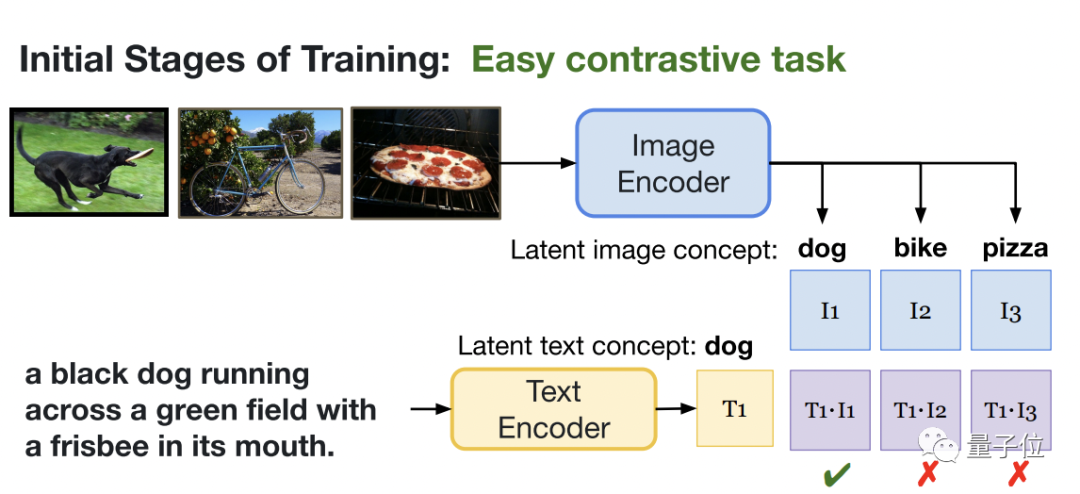

但當(dāng)對(duì)小批樣進(jìn)行采樣時(shí),會(huì)抓取到很多畫(huà)面中有狗的相似圖片,因此僅靠識(shí)別圖片中是否有狗已經(jīng)不能解決問(wèn)題了,該模型必須共享上下文級(jí)信息的語(yǔ)言和視覺(jué)表示,從而產(chǎn)生更細(xì)粒度的對(duì)齊。

此外,不同于CLIP從互聯(lián)網(wǎng)收集構(gòu)建了4億個(gè)圖像-文本對(duì)的數(shù)據(jù)集,BERT-VinVL模型只需不到1%的訓(xùn)練量,但效果并沒(méi)有打折扣。

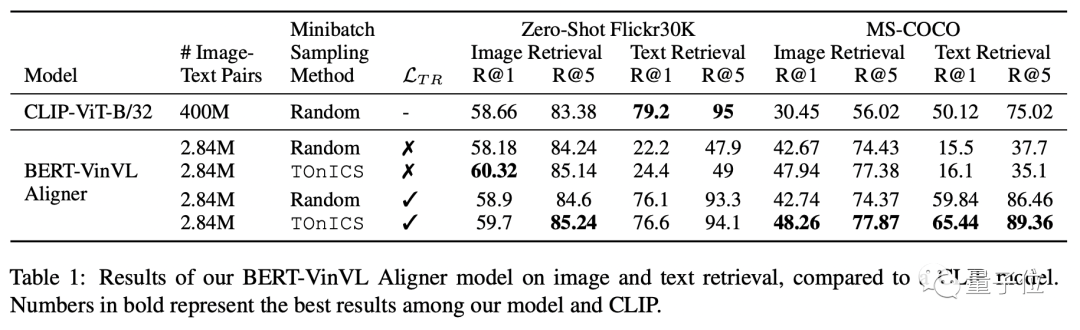

研究人員在MS-COCO和Conceptual Captions上訓(xùn)練BERT-VinVL模型,并將該模型與下游檢索任務(wù)上的CLIP進(jìn)行比較。

實(shí)驗(yàn)結(jié)果發(fā)現(xiàn),BERT-VinVL模型同樣能達(dá)到零樣本學(xué)習(xí)效果,甚至在圖像檢索上表現(xiàn)更好( R@1 提高了 1.5%)。

研究團(tuán)隊(duì)

該篇論文來(lái)自南加州大學(xué)的研究團(tuán)隊(duì),作者分別是Tejas Srinivasan、Xiang Ren和Jesse Thomason。

第一作者Tejas Srinivasan,是南加州大學(xué)GLAMOR實(shí)驗(yàn)室的一年級(jí)博士生,跟隨助理教授Jesse Thomason進(jìn)行多模態(tài)機(jī)器學(xué)習(xí)和語(yǔ)言基礎(chǔ)領(lǐng)域的研究。

他曾在微軟研究院實(shí)習(xí),并在人工智能基金會(huì)短暫地?fù)?dān)任過(guò) NLP 研究科學(xué)家。

之前在卡內(nèi)基梅隆大學(xué)語(yǔ)言技術(shù)學(xué)院完成了碩士學(xué)位,本科畢業(yè)于孟買(mǎi)印度理工學(xué)院機(jī)械工程專業(yè),輔修計(jì)算機(jī)科學(xué)學(xué)位。