風(fēng)格控制水平創(chuàng)新高!南理工&InstantX&小紅書發(fā)布CSGO:簡單高效的端到端風(fēng)格遷移框架

論文鏈接:https://arxiv.org/pdf/2408.16766

項目鏈接:https://csgo-gen.github.io/

亮點直擊

- 構(gòu)建了一個專門用于風(fēng)格遷移的數(shù)據(jù)集

- 設(shè)計了一個簡單但有效的端到端訓(xùn)練的風(fēng)格遷移框架CSGO框架,以驗證這個大規(guī)模數(shù)據(jù)集在風(fēng)格遷移中的有益效果。

- 引入了內(nèi)容對齊評分(Content Alignment Score,簡稱CAS)來評估風(fēng)格遷移的質(zhì)量,有效衡量遷移后內(nèi)容損失的程度。

- 大量的定性和定量研究驗證了本文提出的方法在零樣本風(fēng)格遷移方面取得了先進(jìn)的成果。

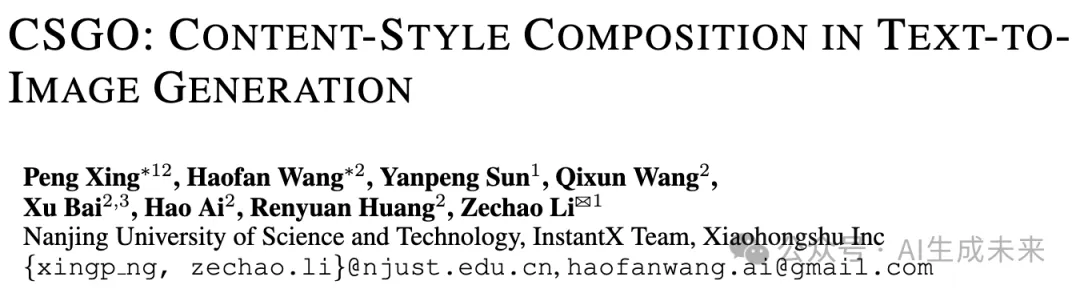

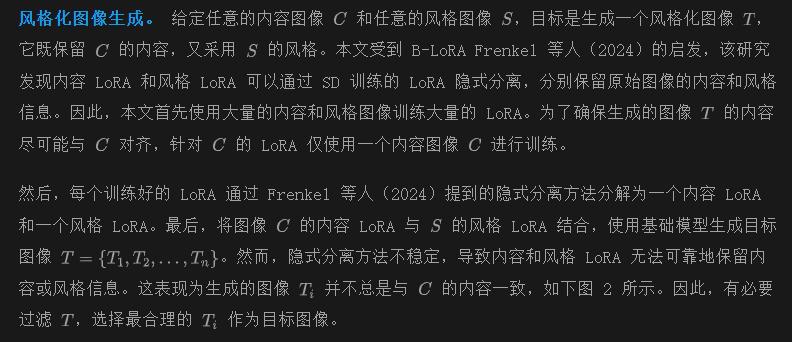

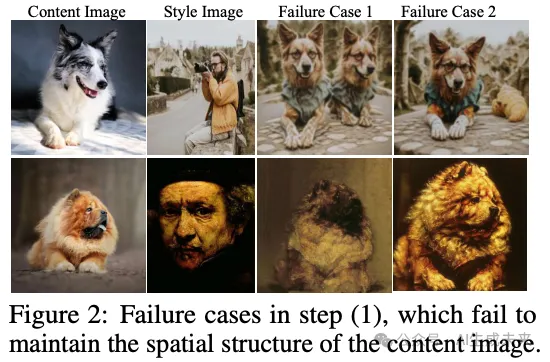

擴(kuò)散模型在受控圖像生成方面展示了卓越的能力,這進(jìn)一步激發(fā)了對圖像風(fēng)格遷移的興趣。現(xiàn)有的工作主要集中在基于訓(xùn)練自由的方法(例如圖像反演),這是由于特定數(shù)據(jù)的稀缺。在本研究中,本文提出了一種用于內(nèi)容-風(fēng)格-風(fēng)格化圖像三元組的數(shù)據(jù)構(gòu)建pipeline,該pipeline生成并自動清理風(fēng)格化數(shù)據(jù)三元組。基于此pipeline,本文構(gòu)建了IMAGStyle數(shù)據(jù)集,這是第一個包含21萬圖像三元組的大規(guī)模風(fēng)格遷移數(shù)據(jù)集,供社區(qū)探索和研究。配備IMAGStyle數(shù)據(jù)集,本文提出了CSGO,一種基于端到端訓(xùn)練的風(fēng)格遷移模型,該模型通過獨立特征注入顯式解耦內(nèi)容和風(fēng)格特征。統(tǒng)一的CSGO實現(xiàn)了圖像驅(qū)動的風(fēng)格遷移、文本驅(qū)動的風(fēng)格化合成以及文本編輯驅(qū)動的風(fēng)格化合成。大量實驗表明,本文的方法在增強圖像生成中的風(fēng)格控制能力方面是有效的。

數(shù)據(jù) pipeline

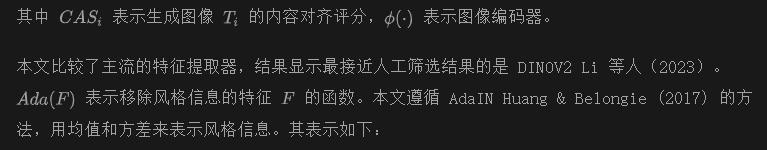

在本節(jié)中,本文首先介紹用于構(gòu)建內(nèi)容-風(fēng)格-風(fēng)格化圖像三元組的提議pipeline。然后,本文詳細(xì)描述構(gòu)建的IMAGStyle數(shù)據(jù)集。

構(gòu)建內(nèi)容-風(fēng)格-風(fēng)格化圖像三元組的pipeline

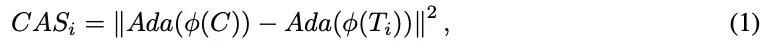

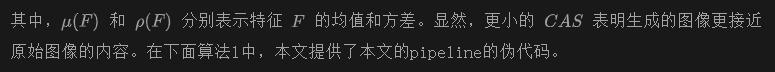

風(fēng)格化圖像清理。 通過人工參與的慢速數(shù)據(jù)清理方法對于構(gòu)建大規(guī)模風(fēng)格化數(shù)據(jù)三元組是不可接受的。為此,本文開發(fā)了一種自動清理方法,以高效地獲得理想且高質(zhì)量的風(fēng)格化圖像T 。首先,本文提出了一個內(nèi)容對齊評分(CAS),它有效地衡量生成圖像與內(nèi)容圖像的內(nèi)容對齊情況。它被定義為生成圖像和原始內(nèi)容圖像的內(nèi)容語義特征(不包含風(fēng)格信息)之間的特征距離。其表示如下:

IMAGSTYLE 數(shù)據(jù)集詳細(xì)信息

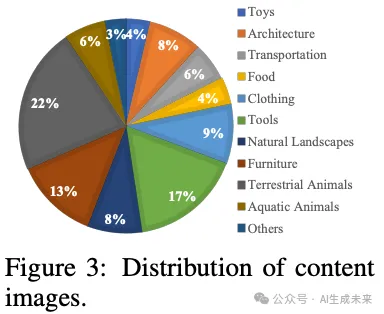

內(nèi)容圖像。 為了確保內(nèi)容圖像具有清晰的語義信息并在訓(xùn)練后便于分離,本文使用顯著性檢測數(shù)據(jù)集 MSRA10K和 MSRA-B作為內(nèi)容圖像。此外,對于素描風(fēng)格化,本文從 ImageNet-Sketch中抽取了1000張素描圖像作為內(nèi)容圖像。內(nèi)容圖像的類別分布如下圖3所示。本文使用 BLIP(Li 等人,2023)為每個內(nèi)容圖像生成一個標(biāo)題。總共訓(xùn)練了11,000張內(nèi)容圖像,并用作內(nèi)容 LoRA。

風(fēng)格圖像。 為了確保風(fēng)格多樣性的豐富性,本文從Wikiart數(shù)據(jù)集中抽取了5000張不同繪畫風(fēng)格的圖像(歷史畫、肖像畫、風(fēng)俗畫、風(fēng)景畫和靜物畫)。此外,本文使用Midjourney生成了5000張涵蓋多種風(fēng)格的圖像,包括古典、現(xiàn)代、浪漫、現(xiàn)實主義、超現(xiàn)實主義、抽象、未來主義、明亮、黑暗等風(fēng)格。總共使用了10,000張風(fēng)格圖像來訓(xùn)練風(fēng)格LoRA。

數(shù)據(jù)集。 基于前文中描述的pipeline,本文構(gòu)建了一個風(fēng)格遷移數(shù)據(jù)集IMAGStyle,該數(shù)據(jù)集包含210,000個內(nèi)容-風(fēng)格-風(fēng)格化圖像三元組作為訓(xùn)練數(shù)據(jù)集。此外,本文從網(wǎng)絡(luò)上收集了248張內(nèi)容圖像,這些圖像包含真實場景、素描場景、人臉和風(fēng)格場景的圖像,以及206張不同場景的風(fēng)格圖像作為測試數(shù)據(jù)集。在測試中,每張內(nèi)容圖像會被轉(zhuǎn)換為206種風(fēng)格。此數(shù)據(jù)集將用于社區(qū)研究風(fēng)格遷移和風(fēng)格化合成。

方法

CSGO框架

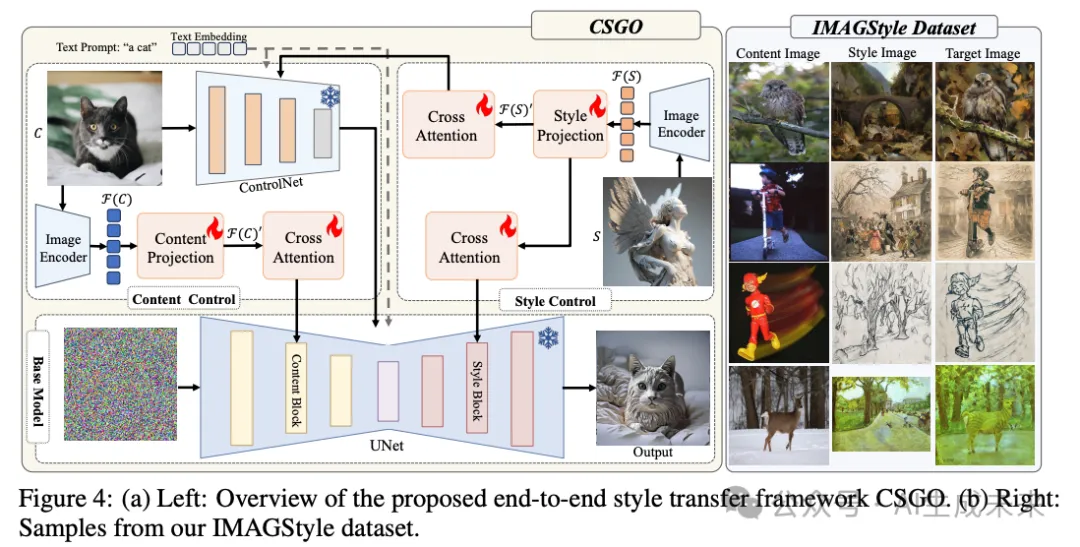

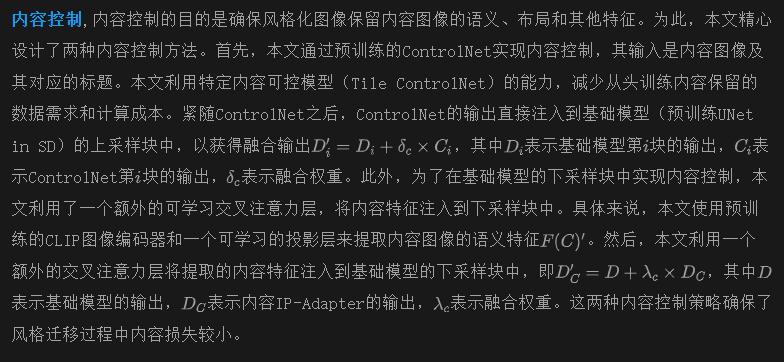

所提出的風(fēng)格遷移模型CSGO,如下圖4所示,旨在實現(xiàn)任意圖像的任意風(fēng)格化,而無需微調(diào),包括素描和自然圖像驅(qū)動的風(fēng)格遷移、文本驅(qū)動的風(fēng)格化合成以及文本編輯驅(qū)動的風(fēng)格化合成。得益于所提出的IMAGStyle數(shù)據(jù)集,CSGO支持端到端的風(fēng)格遷移訓(xùn)練范式。為了確保有效的風(fēng)格遷移和準(zhǔn)確的內(nèi)容保留,本文精心設(shè)計了內(nèi)容和風(fēng)格控制模塊。此外,為了減少內(nèi)容圖像泄露風(fēng)格信息或風(fēng)格圖像泄露內(nèi)容的風(fēng)險,內(nèi)容控制和風(fēng)格控制模塊被明確解耦,對應(yīng)的特征被獨立提取。具體來說,本文將CSGO分為兩個主要組件,并詳細(xì)描述它們。

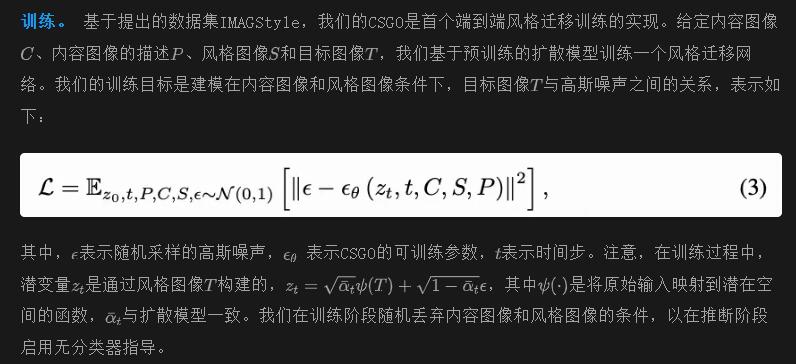

模型訓(xùn)練和推理

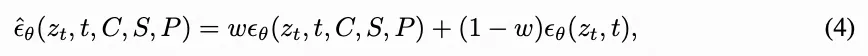

推理。 在推理階段,我們采用無分類器指導(dǎo)。時間步t的輸出表示如下:

其中w表示無分類器指導(dǎo)因子(CFG)。

實驗

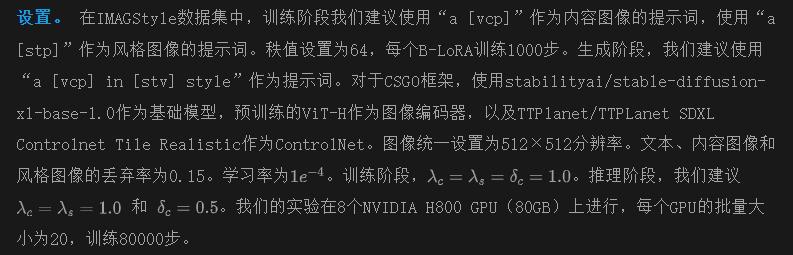

實驗設(shè)置

數(shù)據(jù)集和評估。 使用提出的IMAGStyle作為訓(xùn)練數(shù)據(jù)集,并使用其測試數(shù)據(jù)集作為評估數(shù)據(jù)集。我們采用Somepalli等人提出的CSD評分作為評估指標(biāo)來評估風(fēng)格相似性。同時,我們使用提出的內(nèi)容對齊評分(CAS)作為評估指標(biāo)來評估內(nèi)容相似性。

基線方法。 比較了最近的幾種先進(jìn)的基于反演的風(fēng)格識別方法,包括Chung等人(2024)的StyleID、Hertz等人(2024)的StyleAligned方法,以及基于Transformer結(jié)構(gòu)的StyTR2 Deng等人(2022)。此外,還比較了Wang等人(2024a)的Instantstyle和Junyao等人(2024)的StyleShot(及其細(xì)粒度控制方法StyleShot-lineart),這些方法引入了ControlNet和IPAdapter結(jié)構(gòu)作為基線。在文本驅(qū)動的風(fēng)格控制任務(wù)中,我們還引入了Qi等人(2024)的DEADiff作為基線。

實驗結(jié)果

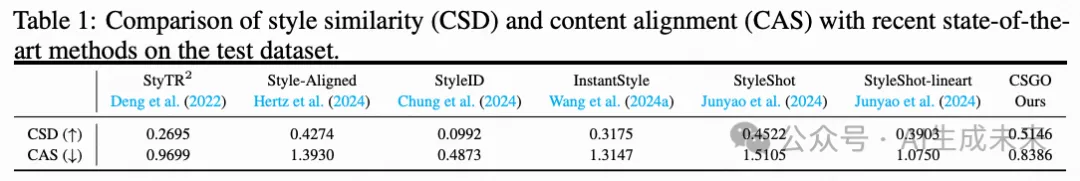

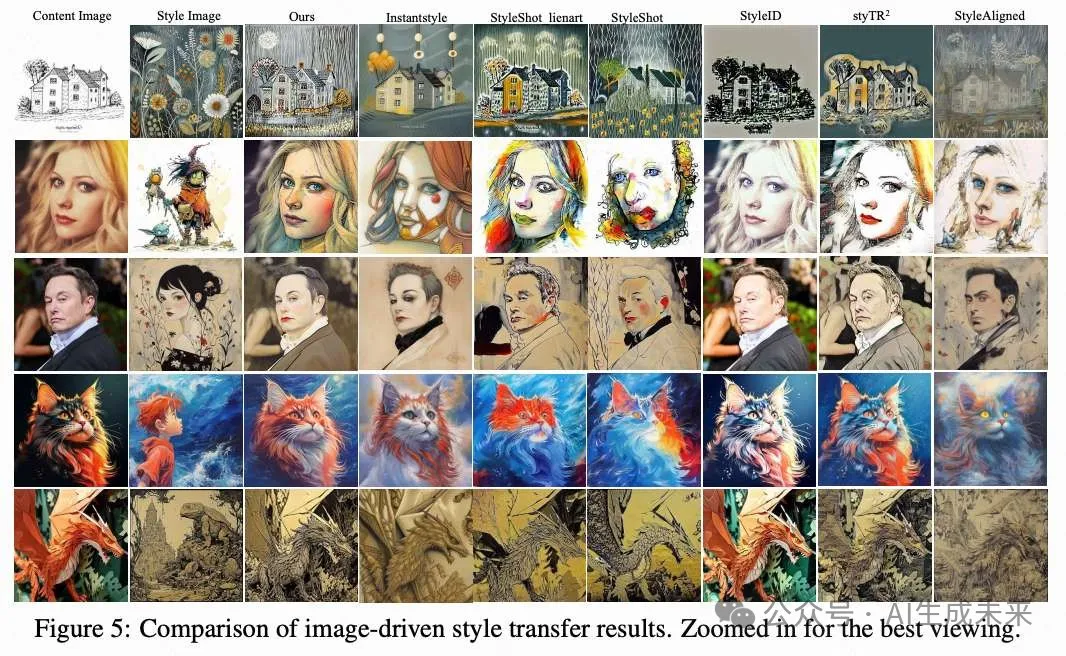

圖像驅(qū)動的風(fēng)格遷移。 在下表1中,展示了所提出方法在圖像驅(qū)動風(fēng)格遷移任務(wù)中與最近先進(jìn)方法的CSD評分和CAS。就風(fēng)格控制而言,我們的CSGO獲得了最高的CSD評分,表明CSGO在風(fēng)格控制方面達(dá)到了最先進(jìn)的水平。由于采用了解耦的風(fēng)格注入方法,所提出的CSGO能夠有效地提取風(fēng)格特征并將其與高質(zhì)量的內(nèi)容特征融合。如下圖5所示,CSGO在自然、素描、人臉和藝術(shù)場景中精確地遷移風(fēng)格,同時保持內(nèi)容的語義。

在內(nèi)容保留方面,可以觀察到基于反演的StyleID和StyleAligned在素描風(fēng)格遷移場景中過于強烈地保持了原始內(nèi)容(CAS非常低)。然而,它們無法注入風(fēng)格信息,因為CSD評分很低。使用線條來控制內(nèi)容的InstantStyle和StyleShot(包括Lineart)受線條細(xì)節(jié)水平的影響,在不同程度上會丟失內(nèi)容(如人臉場景)。所提出的CSGO直接利用內(nèi)容圖像的所有信息,內(nèi)容保留效果最佳。上表1中的定量結(jié)果也表明,所提出的CSGO在實現(xiàn)精確風(fēng)格遷移的同時,保持了高質(zhì)量的內(nèi)容保留。

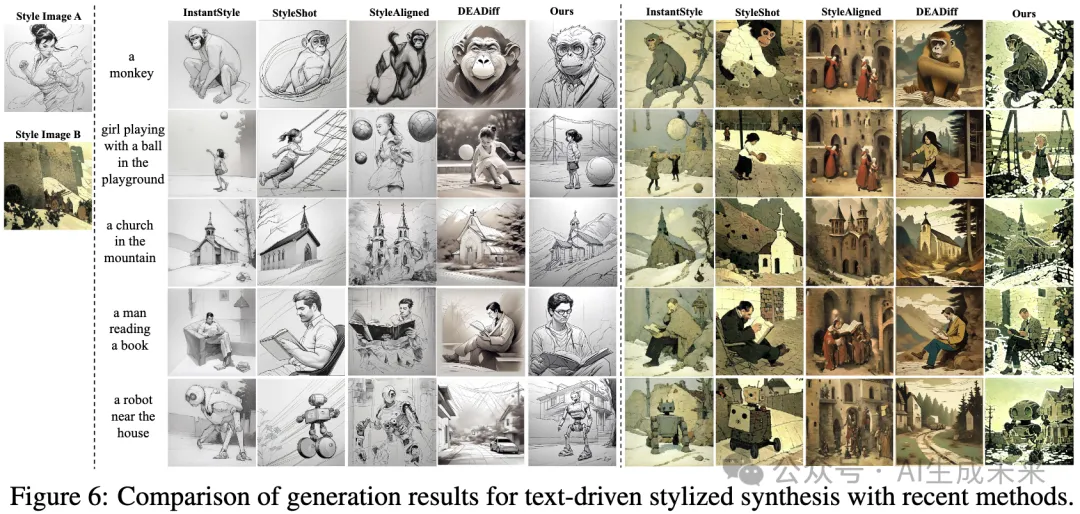

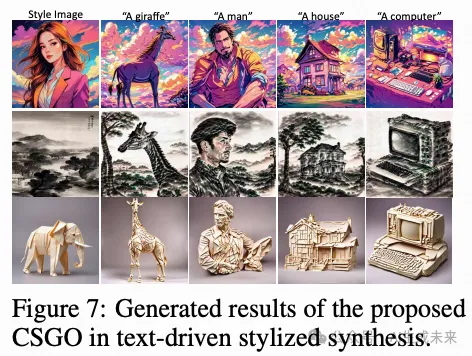

文本驅(qū)動的風(fēng)格化合成。 所提出的方法支持文本驅(qū)動的風(fēng)格控制,即給定一個文本提示詞和一個風(fēng)格圖像,生成具有相似風(fēng)格的圖像。下圖6展示了所提出的CSGO與最先進(jìn)方法的生成結(jié)果對比。在簡單場景中,很直觀地觀察到我們的CSGO更遵循文本提示。這是因為得益于內(nèi)容和風(fēng)格特征的顯式解耦,風(fēng)格圖像僅注入風(fēng)格信息而不暴露內(nèi)容。此外,在復(fù)雜場景中,得益于精心設(shè)計的風(fēng)格特征注入模塊,CSGO在轉(zhuǎn)換文本含義的同時實現(xiàn)了最佳的風(fēng)格控制。如下圖7所示,展示了更多結(jié)果。

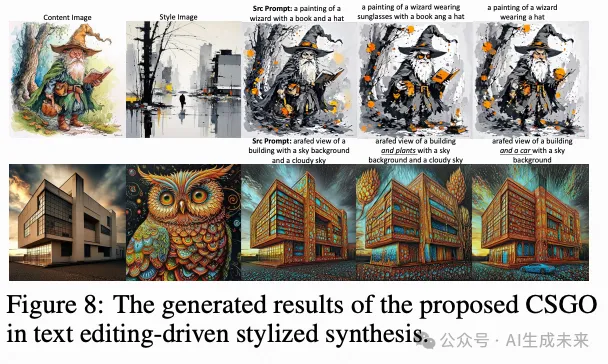

文本編輯驅(qū)動的風(fēng)格化合成。 所提出的CSGO支持文本編輯驅(qū)動的風(fēng)格控制。如下圖8所示,在風(fēng)格遷移過程中,我們保持原始內(nèi)容圖像的語義和布局,同時允許對文本提示詞進(jìn)行簡單編輯。上述優(yōu)秀結(jié)果表明,所提出的CSGO是一個強大的風(fēng)格控制框架。

消融研究

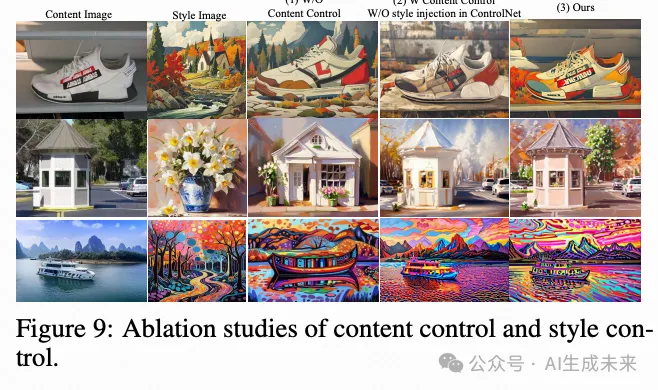

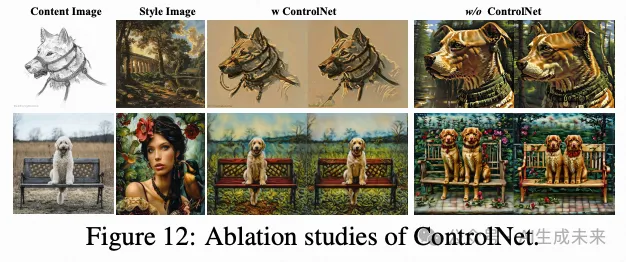

內(nèi)容控制和風(fēng)格控制。我們討論了兩種特征注入方法的影響,如下圖9所示。內(nèi)容圖像必須通過ControlNet注入以保持布局,同時保留語義信息。如果內(nèi)容特征僅通過IP-Adapter注入到CSGO框架中(下圖9(1)),則內(nèi)容特征只保留語義信息。

引入ControlNet注入后,內(nèi)容保留的質(zhì)量得到了提升,如下圖12所示。然而,如果風(fēng)格特征僅注入到基礎(chǔ)UNet中而不通過ControlNet注入,這會削弱生成圖像的風(fēng)格,這可以在上圖9(2)和(3)的對比中觀察到。因此,所提出的CSGO在ControlNet分支中預(yù)先注入風(fēng)格特征,以進(jìn)一步融合風(fēng)格特征,從而增強遷移效果。

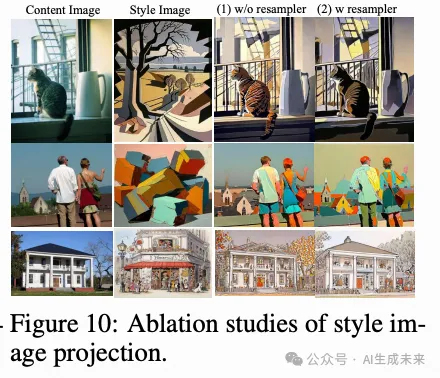

風(fēng)格圖像投影層。 風(fēng)格圖像投影層可以有效地從原始embedding中提取風(fēng)格特征。我們探索了普通線性層和重采樣器結(jié)構(gòu),實驗結(jié)果如下圖10所示。使用重采樣器結(jié)構(gòu)能夠捕捉到更詳細(xì)的風(fēng)格特征,同時避免內(nèi)容泄露。

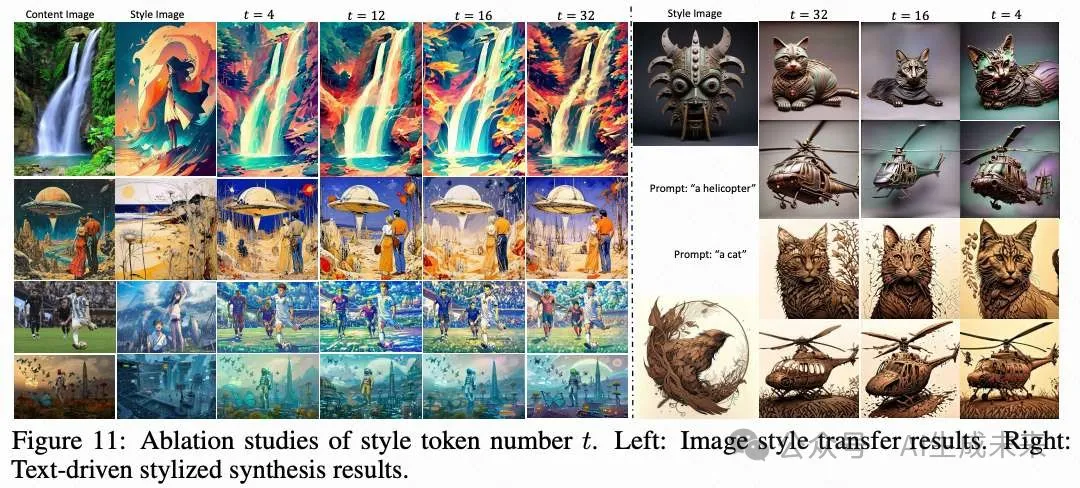

Token數(shù)量。 探討了風(fēng)格投影層中token數(shù)量t對風(fēng)格遷移和文本驅(qū)動風(fēng)格合成結(jié)果的影響。實驗結(jié)果如上圖10所示,隨著t的增加,風(fēng)格控制逐漸變得更好。這與我們的預(yù)期一致,即t影響特征提取的質(zhì)量。更大的t意味著投影層能夠提取出更豐富的風(fēng)格特征。

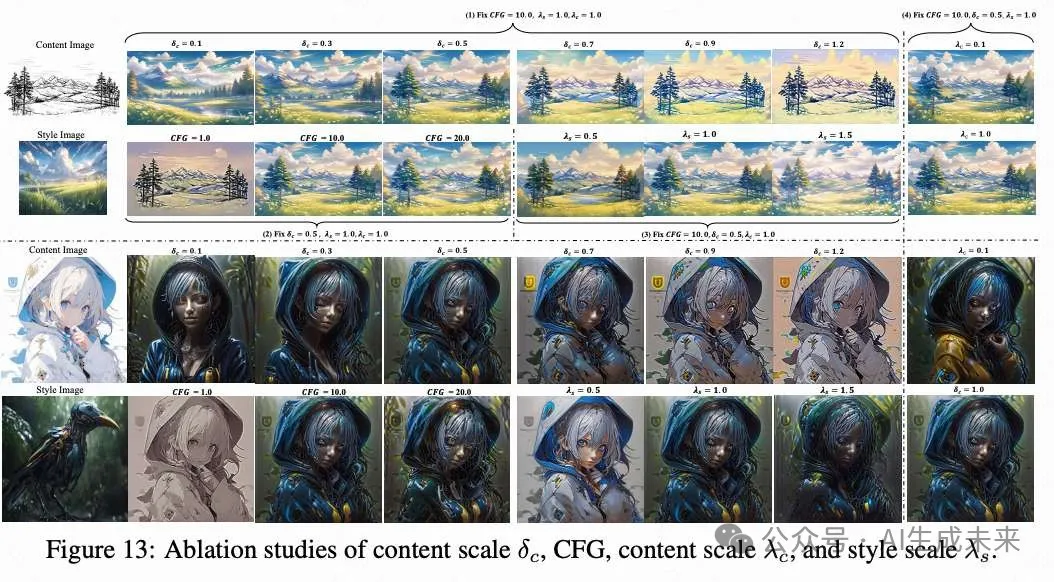

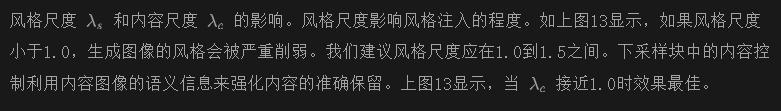

CFG尺度的影響。 無分類器引導(dǎo)增強了文本到圖像模型的能力。所提出的CSGO同樣受CFG尺度強度的影響。正如上圖13所示,引入CFG增強了風(fēng)格遷移效果。

結(jié)論

首先提出了一個用于構(gòu)建內(nèi)容-風(fēng)格-風(fēng)格化圖像三元組的流程。基于此流程,我們構(gòu)建了第一個大規(guī)模風(fēng)格遷移數(shù)據(jù)集IMAGStyle,該數(shù)據(jù)集包含21萬個圖像三元組,涵蓋了廣泛的風(fēng)格場景。為了驗證IMAGStyle對風(fēng)格遷移的影響,我們提出了CSGO,這是一種簡單但高度有效的端到端訓(xùn)練風(fēng)格遷移框架。我們驗證了所提出的CSGO可以在統(tǒng)一框架下同時執(zhí)行圖像風(fēng)格遷移、文本驅(qū)動的風(fēng)格合成和文本編輯驅(qū)動的風(fēng)格合成任務(wù)。大量實驗驗證了IMAGStyle和CSGO對風(fēng)格遷移的有益效果。我們希望我們的工作能夠激勵研究社區(qū)進(jìn)一步探索風(fēng)格化研究。

未來工作。 盡管所提出的數(shù)據(jù)集和框架已經(jīng)取得了非常先進(jìn)的性能,但仍有改進(jìn)的空間。由于時間和計算資源的限制,我們僅構(gòu)建了21萬個數(shù)據(jù)三元組。我們相信,通過擴(kuò)大數(shù)據(jù)集的規(guī)模,CSGO的風(fēng)格遷移質(zhì)量將會更好。同時,所提出的CSGO框架是一個基礎(chǔ)版本,僅驗證了生成風(fēng)格化數(shù)據(jù)集對風(fēng)格遷移的有益效果。我們認(rèn)為,通過優(yōu)化風(fēng)格和內(nèi)容特征提取及融合方法,可以進(jìn)一步提高風(fēng)格遷移的質(zhì)量。

本文轉(zhuǎn)自 AI生成未來 ,作者:Peng Xing等