Still-Moving效果驚艷!無(wú)需定制視頻數(shù)據(jù),DeepMind讓文生定制視頻變得簡(jiǎn)單! 精華

文章鏈接: https://arxiv.org/pdf/2407.08674

github鏈接: https://still-moving.github.io/

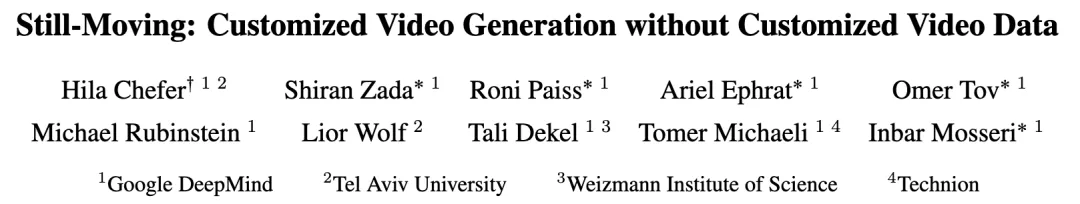

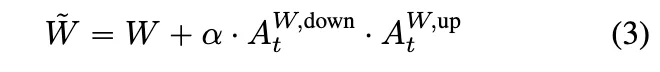

自定義文本生成圖像(T2I)模型最近取得了巨大進(jìn)展,尤其是在個(gè)性化、風(fēng)格化和條件生成等領(lǐng)域。然而,將這些進(jìn)展擴(kuò)展到視頻生成仍處于初期階段,主要原因是缺乏定制視頻數(shù)據(jù)。

本文介紹了Still-Moving,是一種無(wú)需定制視頻數(shù)據(jù)即可自定義文本生成視頻(T2V)模型的新穎通用框架。該框架適用于T2V模型的主要設(shè)計(jì),其中視頻模型是在文本生成圖像(T2I)模型的基礎(chǔ)上構(gòu)建的(例如,通過(guò)擴(kuò)展)。

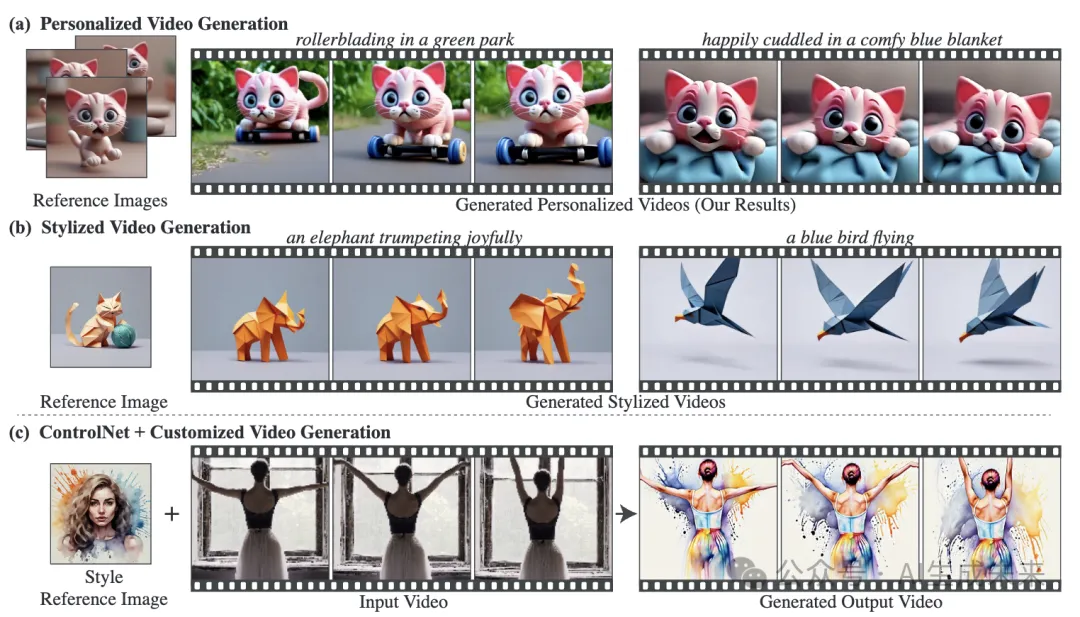

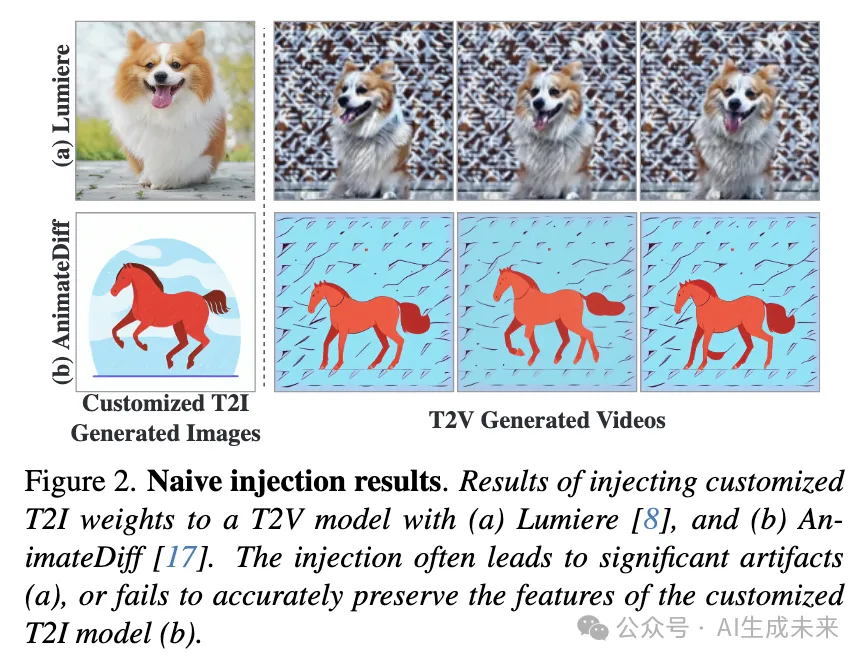

假設(shè)能夠訪問(wèn)僅在靜態(tài)圖像數(shù)據(jù)上訓(xùn)練的定制版本的T2I模型(例如,使用DreamBooth或StyleDrop)。直接將定制T2I模型的權(quán)重插入T2V模型通常會(huì)導(dǎo)致顯著的偽影或?qū)Χㄖ茢?shù)據(jù)的依從性不足。為了解決這個(gè)問(wèn)題,本文訓(xùn)練了輕量級(jí)的Spatial Adapters來(lái)調(diào)整由注入的T2I層產(chǎn)生的特征。重要的是,Adapters是在“凍結(jié)視頻”(即重復(fù)圖像)上訓(xùn)練的,這些視頻是由定制T2I模型生成的圖像樣本構(gòu)建的。

這種訓(xùn)練通過(guò)一種新穎的Motion Adapters模塊得以實(shí)現(xiàn),能夠在靜態(tài)視頻上進(jìn)行訓(xùn)練,同時(shí)保留視頻模型的運(yùn)動(dòng)先驗(yàn)。在測(cè)試時(shí),移除Motion Adapter 模塊,僅保留訓(xùn)練好的Spatial Adapters。這恢復(fù)了T2V模型的運(yùn)動(dòng)先驗(yàn),同時(shí)遵循了定制T2I模型的空間先驗(yàn)。在包括個(gè)性化、風(fēng)格化和條件生成在內(nèi)的多種任務(wù)中展示了本文方法的有效性。在所有評(píng)估場(chǎng)景中,本文的方法無(wú)縫集成了定制T2I模型的空間先驗(yàn)和T2V模型提供的運(yùn)動(dòng)先驗(yàn)。

方法

給定一個(gè)從T2I模型擴(kuò)展而來(lái)的視頻模型,以及一個(gè)從微調(diào)而來(lái)的定制T2I模型,本文的目標(biāo)是實(shí)現(xiàn)將定制權(quán)重?zé)o縫插入V中。簡(jiǎn)單地將M替換為的方法由于特征分布的變化導(dǎo)致不滿意的結(jié)果(下圖2)。

為了緩解這種變化,本文提出訓(xùn)練輕量級(jí)的Spatial Adapters,這些Adapters的任務(wù)是將注入的層的輸出激活投影回的時(shí)間層的分布。該方法的一個(gè)主要挑戰(zhàn)是Adapters應(yīng)該在定制視頻數(shù)據(jù)上進(jìn)行訓(xùn)練,而這種數(shù)據(jù)通常難以獲得。注意,雖然靜態(tài)圖像可以復(fù)制形成(凍結(jié))視頻,但在這些凍結(jié)視頻上進(jìn)行原始訓(xùn)練會(huì)導(dǎo)致運(yùn)動(dòng)生成能力的喪失。為了解決這個(gè)問(wèn)題,本文提出采用新穎的Motion Adapters來(lái)使能在圖像數(shù)據(jù)上進(jìn)行訓(xùn)練而不喪失模型的運(yùn)動(dòng)先驗(yàn)。

Motion Adapters

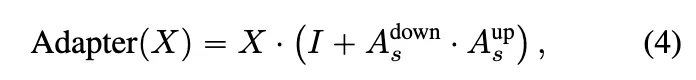

本文方法的一個(gè)關(guān)鍵組件是能夠在凍結(jié)圖像數(shù)據(jù)上訓(xùn)練視頻模型V的權(quán)重。為了在不引入分布外輸入的情況下實(shí)現(xiàn)這一目標(biāo),提出訓(xùn)練輕量級(jí)的Motion Adapters,以控制模型生成視頻中運(yùn)動(dòng)的存在。Motion Adapters在普通、非定制的T2V模型上訓(xùn)練一次。本文的實(shí)現(xiàn)基于時(shí)間注意力投影矩陣的低秩適應(yīng)(LoRA)(見(jiàn)下圖3(a))

所有的 。這里, 是adapter scale,而 和 是adapter 矩陣。矩陣 以隨機(jī)值初始化,而 初始化為零,這樣在訓(xùn)練之前,模型等同于 。

在訓(xùn)練過(guò)程中,設(shè)置 ,并使用模型訓(xùn)練集中的一小部分視頻。對(duì)于每個(gè)視頻,隨機(jī)選擇一個(gè)幀,復(fù)制 次,并用擴(kuò)散去噪目標(biāo)訓(xùn)練adapter層。換句話說(shuō),Motion Adapters被訓(xùn)練生成展示從視頻模型分布中復(fù)制的隨機(jī)幀的凍結(jié)視頻(見(jiàn)上面圖3(a))。一旦訓(xùn)練完成,Motion Adapters就能夠在凍結(jié)數(shù)據(jù)上訓(xùn)練視頻模型權(quán)重。需要注意的是,通過(guò)設(shè)置 ,模型保留其生成運(yùn)動(dòng)的能力。

Motion Adapters控制運(yùn)動(dòng)量的能力可以推廣到負(fù)尺度。例如,當(dāng)設(shè)置 時(shí),模型生成運(yùn)動(dòng)量增加的視頻。因此,除了允許在圖像上定制T2V模型外,Motion Adapters還可以在推理過(guò)程中用于控制生成視頻中的運(yùn)動(dòng)量。

Spatial Adapters

本文方法的核心前提是特征分布的偏差可以通過(guò)簡(jiǎn)單的線性投影來(lái)修正。因此,建議在每個(gè)注入的定制T2I層之后添加Spatial Adapters(見(jiàn)上面圖3(b))。這些adapters的任務(wù)是修正時(shí)間層輸入的分布差距。因此,它們的訓(xùn)練需要通過(guò)整個(gè)視頻模型傳播梯度。與Motion Adapters類(lèi)似,Spatial Adapters實(shí)現(xiàn)為低秩矩陣的乘法。

其中, 和 是特定層的低秩adapter矩陣。與Motion Adapters類(lèi)似, 和 分別以隨機(jī)值和零值初始化,這樣在訓(xùn)練之前,模型等同于。使用擴(kuò)散重建損失在圖像和視頻的組合上訓(xùn)練Spatial Adapters。具體來(lái)說(shuō),使用由定制T2I模型M1生成的圖像和40個(gè)非定制視頻來(lái)保留擴(kuò)展模型的先驗(yàn),按照DreamBooth 的方法進(jìn)行(見(jiàn)上面圖3(b))。對(duì)凍結(jié)視頻使用尺度為 的Motion Adapters,對(duì)先驗(yàn)保留視頻使用尺度為 的Motion Adapters。

實(shí)驗(yàn)

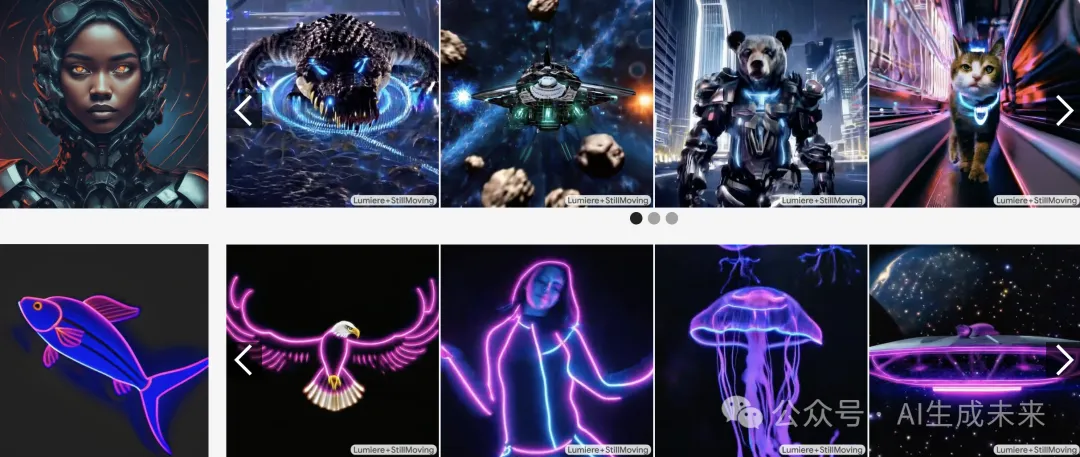

這里展示了廣泛的定性和定量評(píng)估,并將本文的方法與主要baseline進(jìn)行比較。在使用DreamBooth進(jìn)行個(gè)性化和使用StyleDrop進(jìn)行風(fēng)格化的強(qiáng)大定制任務(wù)上進(jìn)行了評(píng)估。此外,展示了本文的方法與ControlNet的結(jié)合,ControlNet能夠在保持原始結(jié)構(gòu)的同時(shí),將現(xiàn)有視頻定制為個(gè)性化對(duì)象或給定風(fēng)格。在兩個(gè)著名的擴(kuò)展T2V模型上展示了結(jié)果,分別是基于Imagen構(gòu)建的Lumiere和基于Stable Diffusion構(gòu)建的AnimateDiff,以證明本文方法的魯棒性。

Baselines

研究者們考慮了三種主要的baselines方法:

- 原始權(quán)重注入:在T2V模型中用定制T2I權(quán)重替換T2I模型權(quán)重,正如Guo等人和Liew等人所應(yīng)用的那樣;

- 權(quán)重插值:在定制權(quán)重和預(yù)訓(xùn)練T2I權(quán)重之間進(jìn)行插值,正如Bar-Tal等人所應(yīng)用的那樣;

- 交錯(cuò)訓(xùn)練:受T2V訓(xùn)練常用方法的啟發(fā),使用以下方法微調(diào)視頻模型中的T2I權(quán)重:(i) 禁用時(shí)間層的定制圖像,和(ii) 啟用時(shí)間層的自然視頻。這個(gè)baseline方法與本文方法的關(guān)鍵區(qū)別在于,最終生成的視頻沒(méi)有像本文的方法框架那樣,明確地使用定制圖像數(shù)據(jù)進(jìn)行監(jiān)督。

評(píng)估數(shù)據(jù)

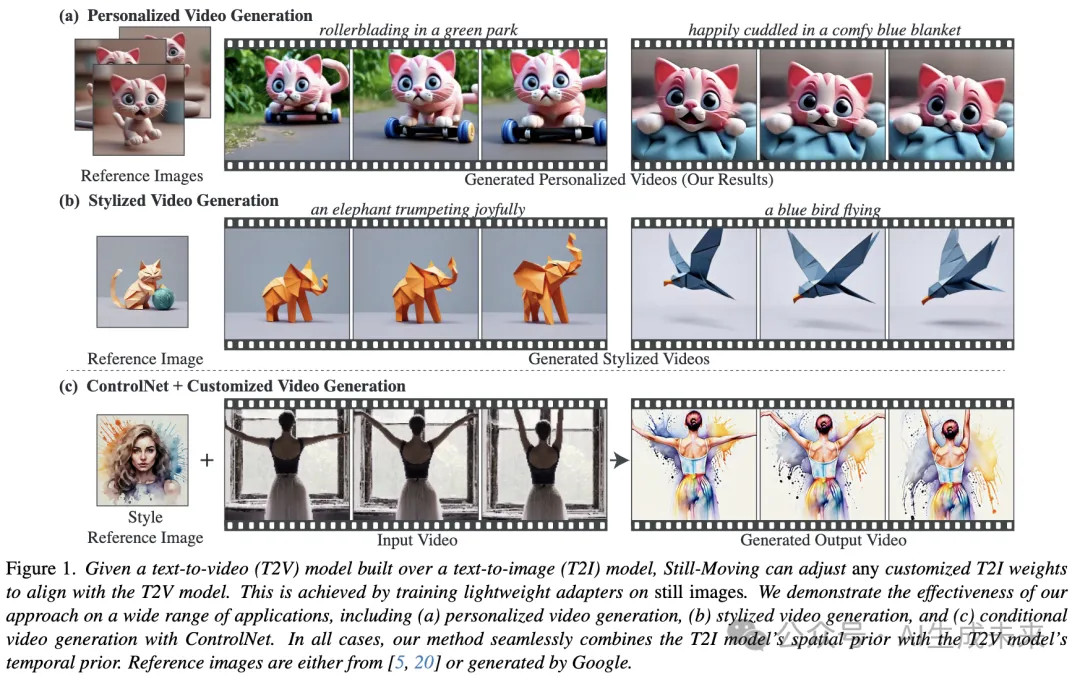

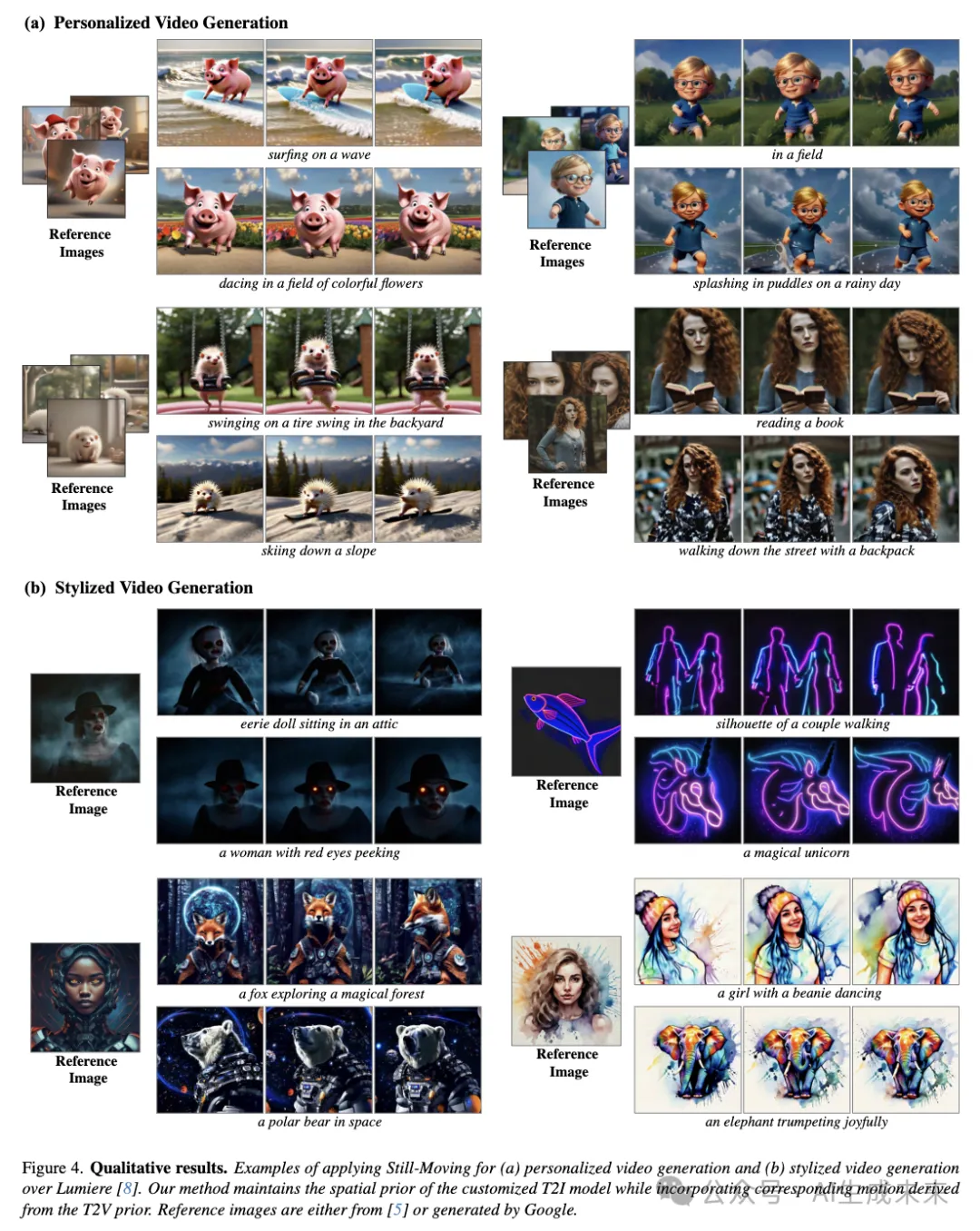

本文構(gòu)建了一個(gè)包含個(gè)性化對(duì)象和風(fēng)格的多樣化數(shù)據(jù)集。對(duì)于個(gè)性化,包括了來(lái)自DreamBooth數(shù)據(jù)集的五個(gè)不同對(duì)象,包括現(xiàn)實(shí)的(例如狗、貓)和分布外的(例如玩具)對(duì)象。對(duì)于風(fēng)格化評(píng)估,使用了Lumiere中展示的三種風(fēng)格,另外還有兩種具有挑戰(zhàn)性的現(xiàn)實(shí)和高度詳細(xì)的風(fēng)格,見(jiàn)圖4。每種風(fēng)格都能夠全面評(píng)估包含不同場(chǎng)景和對(duì)象的廣泛提示。這構(gòu)成了一個(gè)包含10種不同個(gè)性化對(duì)象和風(fēng)格的數(shù)據(jù)集。對(duì)于數(shù)據(jù)集中的每個(gè)項(xiàng)目,生成了10個(gè)在相同隨機(jī)種子和不同提示下的對(duì)比視頻,共計(jì)每個(gè)baseline100個(gè)對(duì)比視頻。

定性結(jié)果

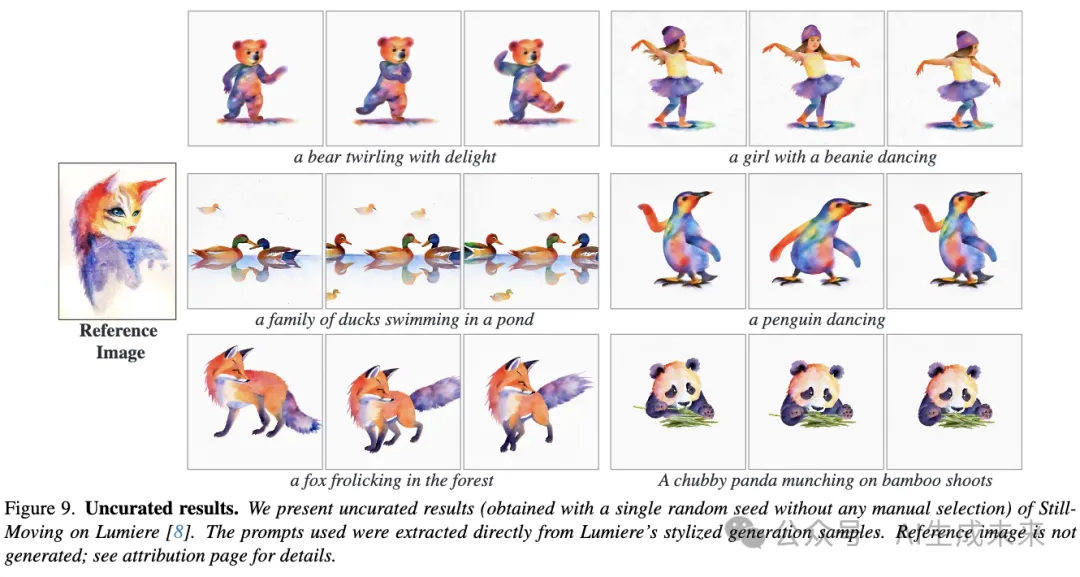

前面圖1、下圖4和圖9展示了本文的方法在Lumiere上應(yīng)用于視頻個(gè)性化和風(fēng)格化時(shí),在各種具有挑戰(zhàn)性的定制T2I模型上獲得的結(jié)果。個(gè)性化角色來(lái)自Avrahami等人或由Google生成。同樣,風(fēng)格參考來(lái)自Hertz等人、Sohn等人或由Google生成。可以看出,本文的方法保持了M1的空間先驗(yàn),同時(shí)匹配了來(lái)自V的創(chuàng)意運(yùn)動(dòng)先驗(yàn)。例如,“水彩飛濺”風(fēng)格(圖4(b))伴隨著飛濺的顏色運(yùn)動(dòng),“恐怖電影”風(fēng)格(圖4(b))結(jié)合了霧氣運(yùn)動(dòng)等。對(duì)于個(gè)性化,本文的方法展示了對(duì)現(xiàn)實(shí)(例如圖4(a)中的女人)和動(dòng)畫(huà)角色(例如圖1中的貓)的內(nèi)在動(dòng)畫(huà)能力,同時(shí)生成了多樣的背景、場(chǎng)景和動(dòng)態(tài)(例如沖浪、跳舞)。

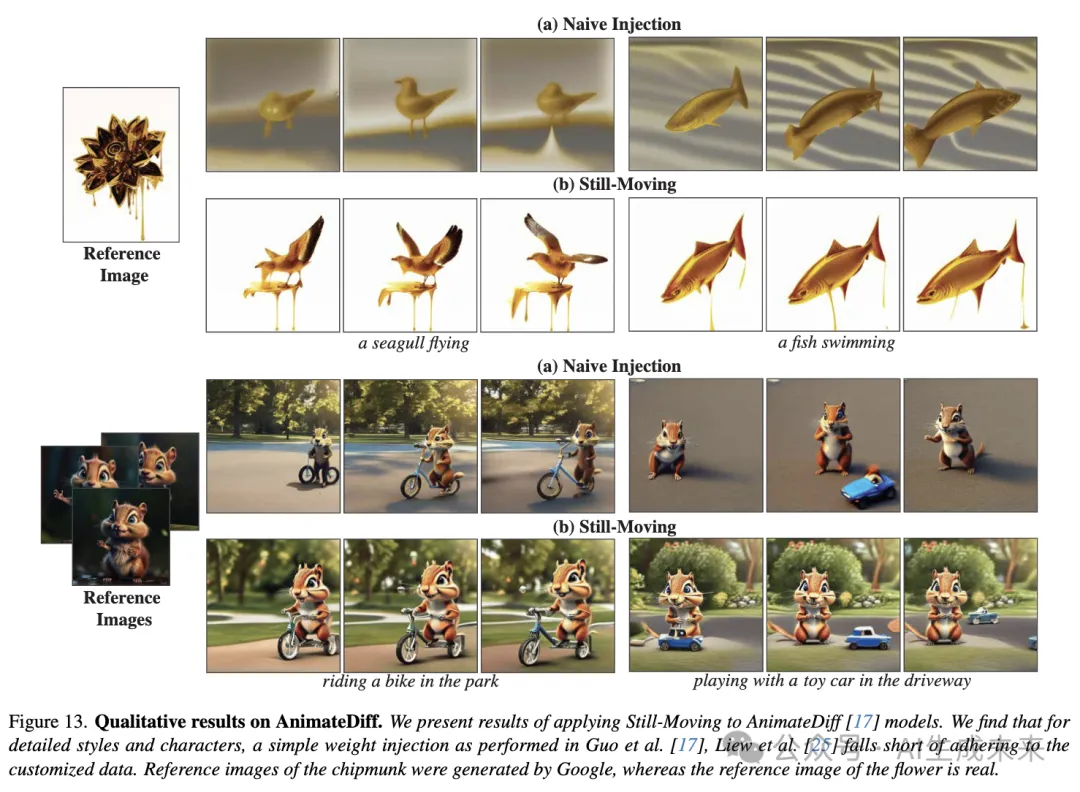

下圖13展示了本文的方法與在AnimateDiff上的原始注入baseline的定性比較。重要的是,AnimateDiff的作者強(qiáng)調(diào)了模型無(wú)縫插入微調(diào)T2I權(quán)重的能力。可以看出,這種方法對(duì)于復(fù)雜的定制數(shù)據(jù)往往會(huì)產(chǎn)生不滿意的結(jié)果。對(duì)于風(fēng)格化,“融化的金色”風(fēng)格(頂部行)顯示出背景失真,并且缺乏該風(fēng)格特有的融化滴落效果。對(duì)于個(gè)性化,小松鼠的特征沒(méi)有被準(zhǔn)確捕捉(例如臉頰和前額的顏色)。此外,小松鼠的身份在不同幀中發(fā)生了變化。相比之下,應(yīng)用本文的方法時(shí),“融化的金色”背景與參考圖像相匹配,模型生成了滴落的運(yùn)動(dòng)。同樣,小松鼠保持了一致的身份,與參考圖像相符。

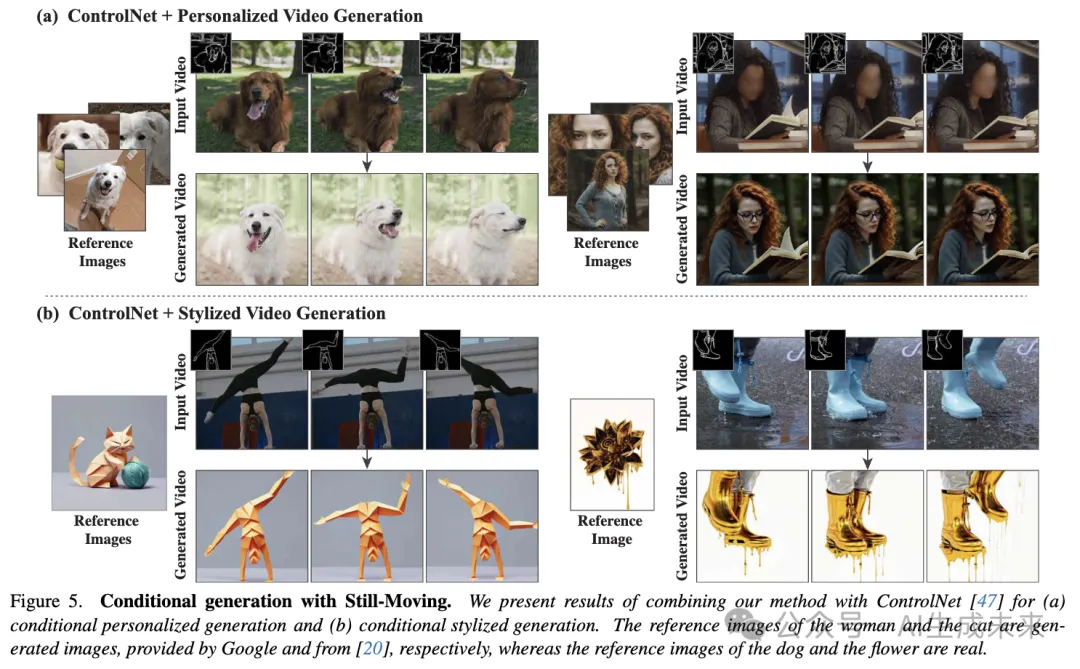

接下來(lái),前面圖1和下圖5展示了本文的方法與ControlNet結(jié)合的結(jié)果。在給定驅(qū)動(dòng)視頻的情況下,本文的方法能夠生成一個(gè)遵循其結(jié)構(gòu)的定制視頻,同時(shí)加入風(fēng)格或角色。例如,圖5頂部一行的視頻被轉(zhuǎn)換為展示參考女性形象,同時(shí)保持驅(qū)動(dòng)視頻的主要特征。有趣的是,ControlNet與Still-Moving的結(jié)合不僅能加入由條件決定的運(yùn)動(dòng),還能加入由風(fēng)格決定的動(dòng)態(tài)運(yùn)動(dòng)。例如,圖5中的“融化的金色”風(fēng)格為場(chǎng)景添加了滴落的運(yùn)動(dòng)。

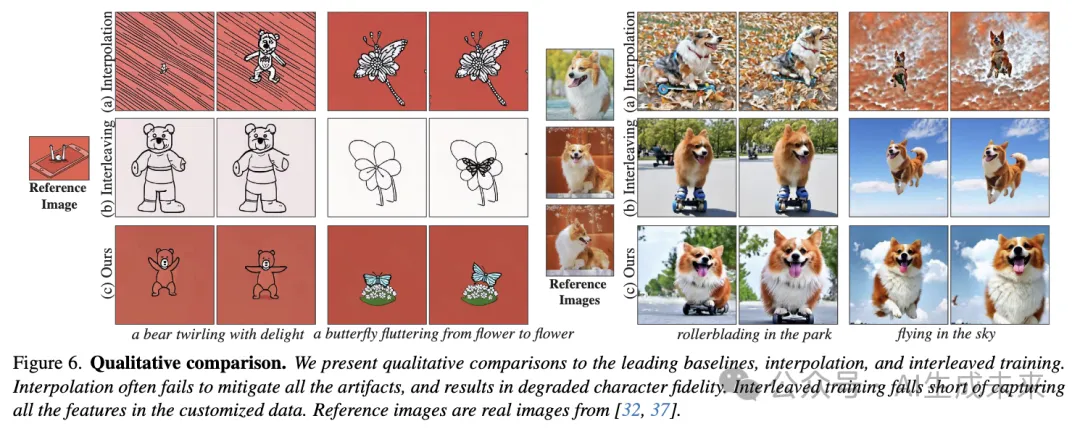

下圖6展示了本文的方法與領(lǐng)先的baseline方法(即插值和交錯(cuò)訓(xùn)練)在評(píng)估數(shù)據(jù)集示例上的定性比較。可以看到,插值baseline在插值過(guò)程中本質(zhì)上丟失了M1的信息。這在圖6中的個(gè)性化示例中最為明顯,插值過(guò)程中狗的身份丟失了。此外,可以看到插值并不總是足以克服分布差距,可能會(huì)保留顯著的偽影。交錯(cuò)訓(xùn)練baseline在兩種情況下都無(wú)法準(zhǔn)確捕捉參考圖像。這可以歸因于baseline方法使用定制數(shù)據(jù)來(lái)修改模型的T2I層,同時(shí)忽略了時(shí)間層。如前面圖2所示,微調(diào)后的空間層與預(yù)訓(xùn)練的時(shí)間層的結(jié)合經(jīng)常會(huì)導(dǎo)致分布偏移,從而導(dǎo)致無(wú)法嚴(yán)格遵循定制數(shù)據(jù)。

定量結(jié)果

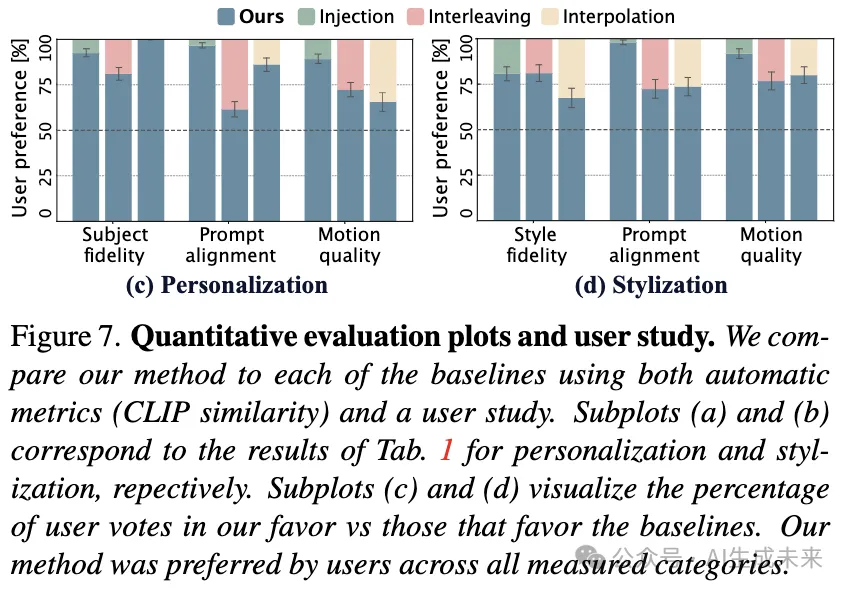

通過(guò)自動(dòng)指標(biāo)和用戶研究對(duì)baseline方法進(jìn)行了定量比較。

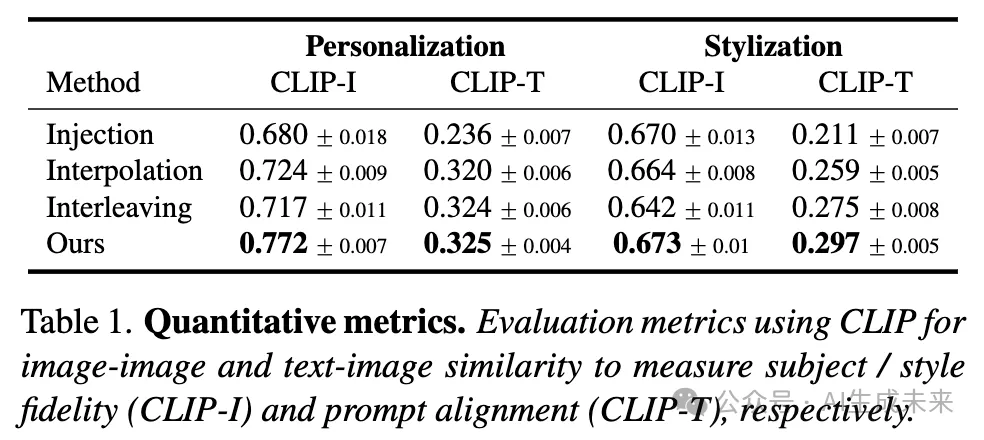

指標(biāo)。根據(jù)圖像定制領(lǐng)域類(lèi)似工作的常見(jiàn)做法,研究者們考慮每幀相對(duì)于驅(qū)動(dòng)提示的CLIP文本-圖像相似度(CLIP-T)和每幀相對(duì)于定制數(shù)據(jù)的圖像-圖像相似度(CLIP-I)。在數(shù)據(jù)集的兩個(gè)子集(個(gè)性化、風(fēng)格化)上的自動(dòng)評(píng)估結(jié)果報(bào)告在下表1和圖7(a)、(b)中。本文的方法在所有評(píng)估子集和所有評(píng)估標(biāo)準(zhǔn)上均顯著優(yōu)于所有baseline方法,如圖7和表1中報(bào)告的標(biāo)準(zhǔn)誤差(SME)所示。圖7中的趨勢(shì)與在定性比較(上圖6)中觀察到的趨勢(shì)類(lèi)似。插值和注入baseline在風(fēng)格化方面表現(xiàn)更好,這可以歸因于個(gè)性化T2I模型的更大分布差距。相反,交錯(cuò)訓(xùn)練baseline無(wú)法適應(yīng)新風(fēng)格,因?yàn)樗鼉H在定制數(shù)據(jù)上訓(xùn)練T2I模型權(quán)重。

重要的是,簡(jiǎn)單地使用定制T2I模型生成單個(gè)圖像并將其復(fù)制形成凍結(jié)視頻,可以獲得非常高的CLIP-I和CLIP-T分?jǐn)?shù)。在缺乏評(píng)估生成運(yùn)動(dòng)質(zhì)量的運(yùn)動(dòng)指標(biāo)的情況下(正如多篇工作指出的[8, 16, 21]),采用用戶研究進(jìn)一步評(píng)估生成視頻的質(zhì)量。研究有31名參與者,每位參與者需對(duì)包含3個(gè)問(wèn)題的20個(gè)比較進(jìn)行投票。這共計(jì)1860票。在每個(gè)比較中,參與者會(huì)看到兩個(gè)隨機(jī)選自比較數(shù)據(jù)集的視頻——一個(gè)由本文的方法生成,另一個(gè)由baseline生成,兩個(gè)視頻都描繪了相同的參考主體/風(fēng)格,并使用相同的提示和種子生成。參與者被要求回答3個(gè)問(wèn)題:

- “哪個(gè)視頻更好地遵循了提供的參考圖像?”

- “哪個(gè)視頻與提供的文本提示更一致?”

- “哪個(gè)視頻顯示了更好的運(yùn)動(dòng)質(zhì)量?”。

如上如圖7(c)、(d)所示,用戶研究結(jié)果在主體保真度和提示一致性方面與自動(dòng)指標(biāo)一致。此外,研究表明,與baseline方法相比,本文的方法生成的視頻在運(yùn)動(dòng)質(zhì)量方面顯著優(yōu)越,如SME所示。

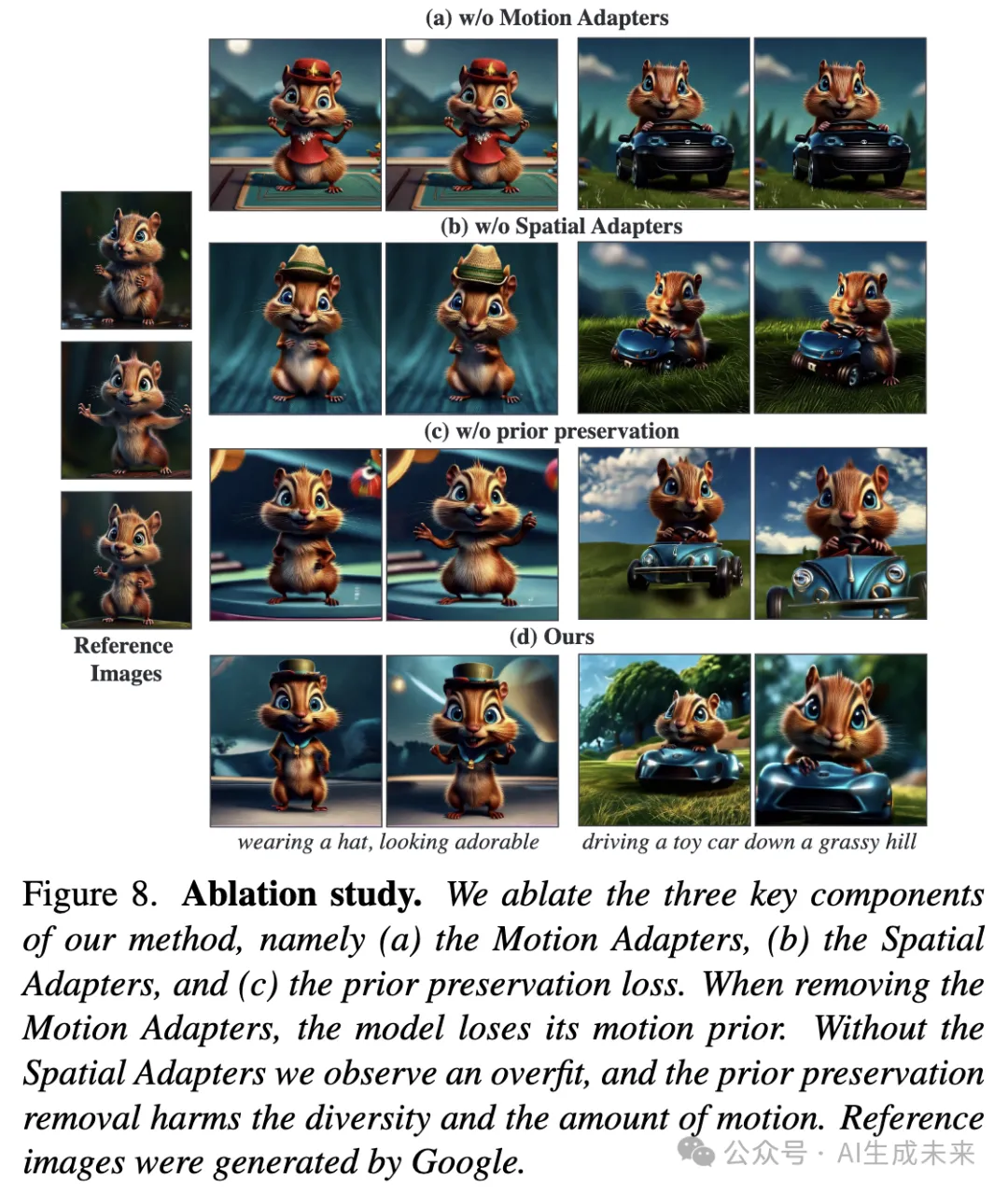

消融研究

對(duì)方法的三個(gè)主要設(shè)計(jì)選擇進(jìn)行了消融實(shí)驗(yàn),即(i)應(yīng)用Motion Adapters,(ii)應(yīng)用Spatial Adapters,和(iii)使用先驗(yàn)保持損失。下圖8展示了這些消融的結(jié)果。當(dāng)移除Motion Adapters并在靜態(tài)視頻上訓(xùn)練時(shí),模型生成的幾乎是靜態(tài)視頻(頂行)。當(dāng)移除Spatial Adapters并改為訓(xùn)練所有網(wǎng)絡(luò)權(quán)重時(shí),觀察到運(yùn)動(dòng)仍然顯著減少(第二行),并且背景不那么多樣化。這可以歸因于優(yōu)化參數(shù)數(shù)量的顯著增加,即使在存在Motion Adapters的情況下,模型也容易過(guò)擬合。這兩個(gè)消融實(shí)驗(yàn)表明,本文方法的兩個(gè)主要新穎組件都是獲得有意義運(yùn)動(dòng)結(jié)果所必需的。最后,當(dāng)移除先驗(yàn)保持組件時(shí)(圖8第三行),模型在一定程度上失去了泛化能力,例如在圖8第一列中,小松鼠沒(méi)有戴帽子。此外,發(fā)現(xiàn)先驗(yàn)保持有助于模型更好地保持其運(yùn)動(dòng)先驗(yàn),沒(méi)有它,運(yùn)動(dòng)有所減少。

限制

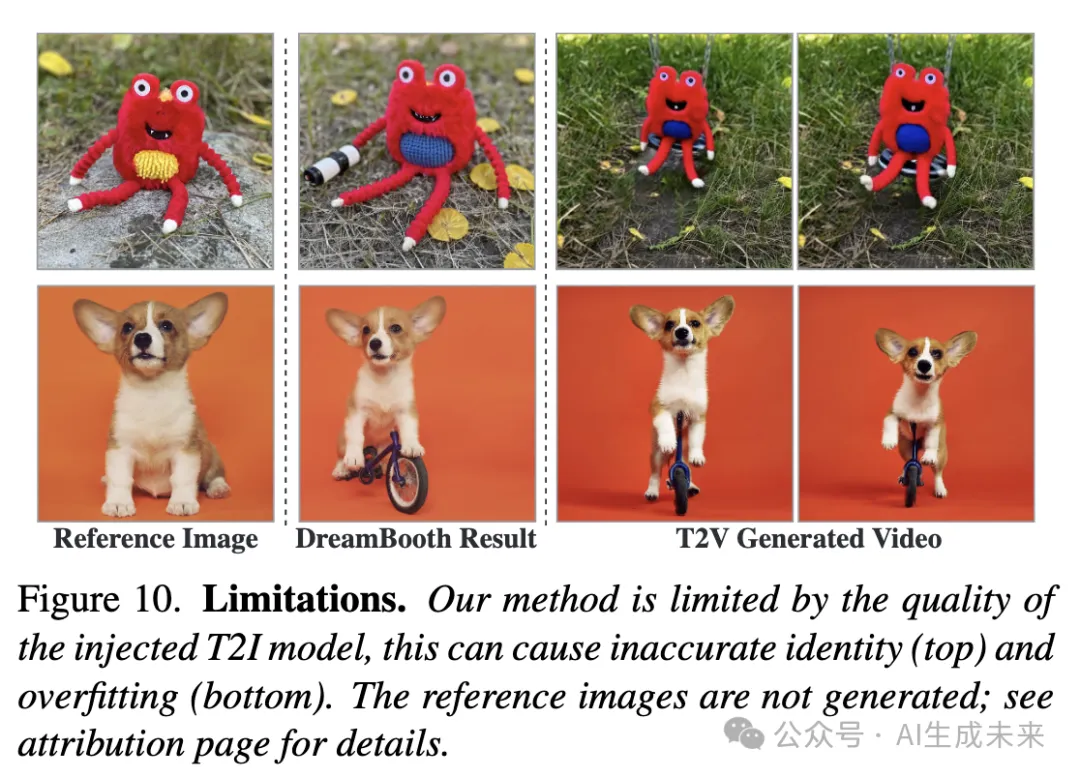

本工作實(shí)現(xiàn)了定制T2I權(quán)重向T2V模型的即插即用注入。因此,結(jié)果本質(zhì)上受限于定制T2I模型的結(jié)果。例如,當(dāng)T2I模型未能準(zhǔn)確捕捉定制對(duì)象的某些特征時(shí),本文模型生成的視頻可能會(huì)表現(xiàn)出類(lèi)似的行為。同樣,如果T2I定制模型對(duì)場(chǎng)景背景過(guò)擬合,本文的方法往往會(huì)產(chǎn)生類(lèi)似的過(guò)擬合(圖10)。

結(jié)論

文本到視頻(T2V)模型變得越來(lái)越強(qiáng)大,現(xiàn)在可以生成復(fù)雜的高分辨率電影鏡頭。然而,如果生成的內(nèi)容能夠被整合到包含特定角色、風(fēng)格和場(chǎng)景的更大敘事中,這些模型在實(shí)際應(yīng)用中的潛力才能得到充分實(shí)現(xiàn)。因此,視頻定制任務(wù)變得至關(guān)重要,但實(shí)現(xiàn)這一目標(biāo)的方法論仍然探索不足。

這項(xiàng)工作克服了實(shí)現(xiàn)這一目標(biāo)的一個(gè)主要挑戰(zhàn),即缺乏定制視頻數(shù)據(jù)。開(kāi)發(fā)了一個(gè)新穎的框架,直接將圖像領(lǐng)域的巨大進(jìn)展轉(zhuǎn)化到視頻領(lǐng)域。重要的是,本文的方法是通用的,可以應(yīng)用于任何基于預(yù)訓(xùn)練的T2I模型構(gòu)建的視頻模型。本文的框架揭示了T2V模型所學(xué)習(xí)到的強(qiáng)大先驗(yàn),正如成功生成從未見(jiàn)過(guò)運(yùn)動(dòng)的特定主題的運(yùn)動(dòng)所證明的那樣。

本文轉(zhuǎn)自 AI生成未來(lái) ,作者:Google 等